Nur noch eine Woche bis zur Handelsblatt KI-Konferenz in München am 15. Und 16. März

Verpassen Sie nicht den zweitägigen exklusiven KI-Erfahrungsaustausch mit Fei Yu Xu, Jürgen Schmidhuber, Frank Ruff, Bernd Heinrichs, Reiner Kraft, Norbert Gaus, Martin Hoffmann und Annika Schröder und vielen anderen Top Speakern.

Hier der Link zur Konferenz und dem Interview, das ich dem Handelsblatt vorab gegeben habe.

Viele Grüße

Jörg Bienert

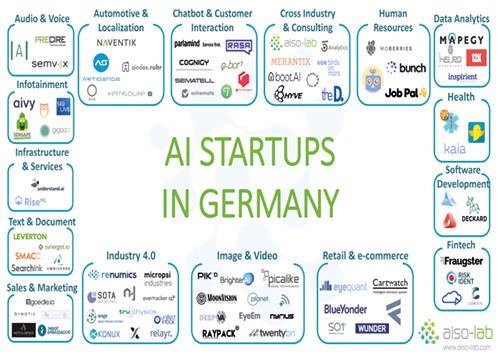

Europa hat eine aufstrebende und prosperierende Industrie für künstliche Intelligenz. Deutschland steht an zweiter Stelle als eines der robustesten KI-Ökosysteme in Europa. Berlin ist der zentrale KI-Hub für 30 KI-Unternehmen, gefolgt von München, Hamburg und Frankfurt am Main.

In diesem Artikel stellen wir Ihnen alle AI-Start-ups in Deutschland vor, basierend auf ihrer Expertise und mit einer kurzen Einführung zu jedem Unternehmen. Und da ein Bild mehr sagt als tausend Worte, haben wir für Sie alle Firmenlogos in einem Bild zusammengefasst, das Ihnen zum Download zur Verfügung steht.

Audio & Voice

Aaron.ai nutzt die Künstliche Intelligenz, um Unternehmen dabei zu unterstützen, Kundenwünsche in natürlicher Sprache zu verstehen und nach Belieben zu bearbeiten.

Precire Technologies hat die PRECIRE-Technologie entwickelt, die Sprache entschlüsselt und faszinierende Einblicke in das Zusammenspiel von Persönlichkeit, Sprache und Verhalten ermöglicht.

SemVox bietet effiziente und sichere Lösungen und Technologien für die Sprachsteuerung, multimodale Mensch-Maschine-Interaktion und intelligente virtuelle Assistenzsysteme, basierend auf der neuesten KI-Technologie und die hocheffizienten ODP S3-Software (Ontology-based Dialog Platform).

Automotive & Lokalisierung

Sie suchen eine Wohnung im Ruhrgebiet? Dann wird die Suchmaschine, die Aindex entwickelt hat, Ihnen die Suche nach der für Sie passenden Wohnung im Ruhrgebiet erleichtern.

Artisense entwickelt führende Technologien aus den Bereichen Computer Vision und Künstliche Intelligenz, die hochskalierbare, kosteneffektive Dynamic Global Mapping für GPS-unabhängige, autonome Navigation ermöglichen.

AVA kombiniert große Datenmengen, verteiltes Computing, Mustererkennung und künstliche Intelligenz, um die Sicherheit von Einzelpersonen, Organisationen, Unternehmen, Städten und Ländern auf ein völlig neues Niveau zu heben.

Die e4 QUALIFICATION GmbH steht für umfassende Qualifizierung und Beratung im gesamten Automotive-Prozess, von den ersten Entwicklungsschritten bis zum Kundenkontakt beim Händler vor Ort. Die e4 qualification GmbH bietet ein umfassendes Portfolio zur Kompetenzerweiterung von Fach- und Führungskräften aus den Bereichen Maschinenbau und Automotive.

Naventik wurde als Spin-off der Technischen Universität Chemnitz gegründet. Die Mission von Naventik ist es, leistungsstarke Fahrzeuglokalisierungstechnologie für Massenmarktanwendungen bereitzustellen.

Terraloupe arbeitet zusammen mit seinen Partnern am innovativen Vorsprung der Technologie, um aktuelle Forschung mit realen Geschäftsanwendungen zu verbinden.

Chatbot und Kundeninteraktion

Chatshopper möchte die Modesuche durch die Einführung des Bot Emma, der Produktvorschläge auf der Grundlage Ihrer Einkaufswünsche bereitstellt, einfach und angenehm gestalten.

Cognigy bietet eine Technologie für natürliche Konversation in Unternehmen, die skalierbar, prüfbar und in hohem Maße anpassbar ist.

E-bot7 bringt künstliche Intelligenz in den Kundenservice und hilft Unternehmen, eine höhere Effizienz im Kundenservice zu erreichen. Das System analysiert eingehende Nachrichten und liefert den Agenten präzise Antwortvorschläge.

Solvemate - Fredknows ist eine Technologieplattform, die den Kundensupport führender Unternehmen automatisiert. Seine virtuellen Agenten ermöglichen Self-Service-Support mit nahezu sofortigen Lösungen.

parlamind ist eine Künstliche Intelligenz (KI) für Kundenbetreuer. Basierend auf den neuesten Forschungsergebnissen in den Bereichen Natural Language Processing und Machine Learning wird die eingehende Kundenkommunikation analysiert, geführt und selbstständig beantwortet und arbeitet so nahtlos mit den menschlichen Kollegen als Mitglied des Kundendienstteams zusammen.

Der Open Source Rasa Stack besteht aus maschinellen Lernbibliotheken für Sprachverstehen (Rasa NLU) und Dialogmanagement (Rasa Core). Diese werden von Tausenden von Entwicklern weltweit verwendet, um intelligente Bots und Assistenten zu bauen.

Ryter ist eine AI-basierte SaaS-Plattform zur Automatisierung von Expertenwissen und zur Erstellung interaktiver, skalierbarer Module.

Semantelli-Lösungen werden auch von Unternehmen im Gesundheitswesen eingesetzt, um unerwünschte Arzneimittelereignisse zu verwalten, die von Patienten in Social Media, mobilen Apps und Apps kommentiert werden.

Twyla hilft Ihnen, Ihre Kundensupport-Gespräche durch Chatbots zu automatisieren, die aus den Gesprächen zwischen Ihren Agenten und Ihren Kunden lernen.

Cross-Industry & Beratung

5Analytics ist ein Start-up aus dem Raum Stuttgart. Es wurde 2016 gegründet und unterstützt innovative Unternehmen, die sich mit Themen wie Digitalisierung oder Industry 4.0 beschäftigen.

aiso-lab baut Künstliche Intelligenz-Lösungen für Unternehmen. Das Angebot reicht von Einführungsvorträgen und Schulungen über die Durchführung von detaillierten Evaluierungsworkshops bis hin zur kompletten Produktentwicklung und Bereitstellung von dedizierten Hardware-Appliances.

Birds on mars bringt Unternehmen, Teams und Einzelpersonen mit den wachsenden Möglichkeiten der Künstlichen Intelligenz zusammen und schliesst die Lücke zwischen Tradition und Transformation.

Boot. AI ist ein auf künstliche Intelligenz spezialisiertes Unternehmen. Durch die Analyse großer Datenmengen sollen die Kunden dabei unterstützt werden, bessere Entscheidungen zu treffen und ihre internen Prozesse zu rationalisieren.

Das Ziel von City.AI ist es, die KI zu verbessern, indem das Problem der Anwendung von KI proaktiv mit den richtigen Leuten in Städten auf der ganzen Welt angegangen wird. Lokale Botschafter sind das Rückgrat von CITY.AI und stehen an der Spitze des Wachstums und der Förderung dieser lebendigen Gemeinschaft.

Develandoo ist ein Software-Beschleuniger, der sich auf den Aufbau von Early-Stage-Projekten auf Basis der KI-Technologie spezialisiert hat.

Explosion AI ist ein digitales Unternehmen, das sich auf Künstliche Intelligenz und Natural Language Processing spezialisiert hat. Es entwirft benutzerdefinierte Algorithmen, Anwendungen und Datenbestände.

Ewald und Rössing ist ein eingespieltes, hoch spezialisiertes Unternehmen, das Unternehmen in und vor akuten Krisensituationen unterstützt und berät. Ihr Ziel ist es, die Wahrnehmung der Unternehmen bei politischen, gesellschaftlichen, medialen und wirtschaftlichen Akteuren zu schützen.

Ziel von Hyve ist es, bahnbrechende Produktinnovationen, Dienstleistungen und Geschäftsmodelle innerhalb eines End-to-End-Prozesses zu entwerfen und zu entwickeln.

LIQUID NEWSROOM ist ein Technologieunternehmen mit einem starken Beratungsarm. Ihr Fokus liegt auf künstlicher Intelligenz in der Beratung und um dies zu erreichen, baut das Unternehmen eine eigene Plattform zur Analyse von Märkten auf, um die DNA des Marktes zu entschlüsseln.

Luminovo ist ein lernendes Unternehmen, das Unternehmen bei der Entwicklung maßgeschneiderter Anwendungen unterstützt. Es wurde von einem Team von KI-Experten der Stanford University gegründet, die bereits bei Google, Amazon, Intel und McKinsey gearbeitet haben.

Merantix ist ein Forschungslabor und Venture Builder im Bereich der Künstlichen Intelligenz. Das einzigartige Team von KI-Forschern und projektübergreifenden Technologie-Stacks ermöglicht es Merantix, Projekte sehr effizient umzusetzen.

Projekt A ist die operative VC, die ihren Unternehmen Kapital, ein umfangreiches Netzwerk und exklusiven Zugang zu einem breiten Spektrum an operativer Expertise bietet.

Solandeo ist seit 2013 als wettbewerbsfähiger Messstellenbetreiber tätig und verfügt über ein deutschlandweites Netz von Installationspartnern. Dies ermöglicht eine schnelle und flexible Installationsplanung für Zähler, Steuerungen oder Batteriespeicher

Soundreply wurde gegründet, um Menschen on-the-job zu trainieren und zu coachen - mit komplexen Maschinen und Fahrzeugen in unternehmenskritischen Umgebungen, sowohl am Boden als auch in der Luft.

The D. ist ein Full-Service Power-Force-Unternehmen, das tiefes technologisches Know-how für verschiedene Branchen in den Bereichen API-Entwicklung, strategische Beratung und Software-Entwicklung bietet. Es ist spezialisiert auf Cybersicherheit und Künstliche Intelligenz.

Unternehmertum bietet Gründern und Start-ups einen kompletten Service von der ersten Idee bis zum Börsengang. Ein Team aus erfahrenen Unternehmern, Wissenschaftlern und Managern unterstützt Gründer bei der Entwicklung ihrer Produkte, Dienstleistungen und Geschäftsmodelle.

Valculus unterstützt die digitale Transformation von Geschäftsprozessen und bietet maßgeschneiderte Datenlösungen - basierend auf fortschrittlicher KI-Technologie und Analytik.

VUI.Agency mit Sitz in München bietet Unternehmen aller Branchen Voice User Interface Technologie. VUI.Agency ist sowohl auf die Entwicklung als auch auf die Strategieberatung im Bereich Voice Interaction Design spezialisiert.

Datenanalyse

Ein technologiegetriebenes Forschungsunternehmen, das intelligente Algorithmen mit einem tiefen Verständnis der Technologielandschaft kombiniert, um Unternehmen dabei zu unterstützen, immer einen Schritt voraus zu sein.

Alexander Thamm wurde 2012 in München gegründet und ist das erste Unternehmen, das sich ausschließlich auf Analytik, Datenwissenschaft und Großdaten spezialisiert hat. Ziel ist es, Kunden bei der Generierung von Wettbewerbsvorteilen und Mehrwert durch die Nutzung großer Datenmengen zu unterstützen.

Digital Helix entwickelt ein Portfolio von Start-up-Unternehmen in der digitalen Gesundheitsbranche. Sie beraten auch die großen Marktteilnehmer, die digitale Innovationen umsetzen.

Heurolabs konzentriert sich auf Künstliche Intelligenz und maschinelles Lernen. Es macht diese Technologien verfügbar und zugänglich durch eine hochgradig abstrahierte Sammlung von APIs, die sowohl für private als auch für öffentliche Clouds verfügbar sind.

Inspirient vereinfacht die Datenanalyse mit Künstlicher Intelligenz, indem es automatisch nach Einblicken in Ihre Geschäftsdaten sucht.

Mapegy baut die Innovationsgrafik, die intelligentere, schnellere und bessere Forschung und Entwicklung ermöglicht. Das Unternehmen Big Data and Visual Analytics bietet ein einzigartiges SaaS, das Innovatoren dabei unterstützt, globale Innovationen abzubilden, um die Punkte, die von der Technologie zum Produkt führen, miteinander zu verbinden.

QuantCo nutzt die Expertise in den Bereichen Datenwissenschaft, Technik und Wirtschaft, um Unternehmen bei der Umsetzung von Daten in Entscheidungen zu unterstützen. QuantCo hat seinen Hauptsitz in Boston und unterhält Büros in Berlin, Tokio und Zürich.

Mit der aktuellen Fülle an Informationen und zunehmenden Datenschutzbedenken und -vorschriften ist es das Hauptziel von Statice, komplexe und professionelle Datenanalysen mit datenschutzfreundlichen Technologien zu ermöglichen.

Fintech

collectAI bietet AI-basierte Inkassodienstleistungen an, um seine Kunden bei der Verwaltung ihrer Forderungen zu unterstützen. Die hochentwickelte Technologie steigert die Rendite und verbessert das Kundenerlebnis, indem sie einen Ausgleich zwischen Inkassotarifen, Kosten und Kundenbindung schafft.

Fraugster ist ein deutsch-israelisches Betrugsbekämpfungsunternehmen mit dem Ziel, Betrug zu unterbinden und die Gewinne der Kunden zu steigern. Um dies zu erreichen, haben sie eine Technologie der Künstlichen Intelligenz entwickelt, die hohe Genauigkeit mit maschineller Skalierbarkeit verbindet.

MotionsCloud bietet eine intelligente Schadenlösung für Sachversicherer, um Schadenprozesse zu rationalisieren und zu automatisieren. Die Lösung reduziert die Durchlaufzeit von Schadenfällen von Tagen auf Stunden, senkt die Schadenaufwendungen um bis zu 75 % und verbessert das Schadenerlebnis für den Kunden durch mobile, künstliche Intelligenz (KI-Bilderkennung) und videofähige Technologien, die sich in Legacy-Systeme integrieren lassen.

Risk Ident ist ein Softwareentwicklungsunternehmen mit Sitz in Deutschland und den USA, das Betrugsbekämpfungslösungen für Unternehmen aus den Bereichen E-Commerce, Telekommunikation und Finanzwesen anbietet.

Health

Mit einer Leidenschaft für Technologie und Fachwissen im Gesundheitswesen entwickelt Cellmatiq Produkte mit künstlicher Intelligenz, die sowohl Patienten als auch medizinischem Fachpersonal zugute kommen. Ihre Aufgabe ist es, Mediziner bei der komplexen Bildanalyse zu unterstützen und künstliche Intelligenz (KI) einzusetzen, um filigrane anatomische Strukturen automatisch zu erkennen.

Cara von HiDoc Technologies ermöglicht es Patienten mit chronischen Verdauungsbeschwerden, ein besseres Leben zu führen. Gohidoc nimmt die Verdauungsgesundheit über die Pille hinaus und führt Verhaltens-, Mikroben- und Ernährungsdaten zusammen.

healthcare.ai nutzt maschinelle Lernen im Gesundheitswesen. Sie tun dies, indem sie die für das Gesundheitswesen spezifischen Funktionen einbinden und den Arbeitsablauf bei der Erstellung und Bereitstellung von Modellen vereinfachen.

kaia health bietet eine app-basierte digitale Therapie mit Schwerpunkt auf chronischen Schmerzen an, die die effektivsten Offline-Behandlungen in digitale Therapien umwandelt.

xbird entwickelt ausgefeilte Algorithmen für das maschinelle Lernen, die Sensordaten von Smartphones und Wearables analysieren, um kritische Gesundheitsrisiken vorherzusagen und zu verhindern.

Human Resources

Die Bunch Plattform ermöglicht es Unternehmen, hochkarätige Teams zu bilden und ihre Kultur so zu gestalten, dass sie das Unternehmenswachstum ankurbeln können.

Jobpal baut AI-basierte Chatbots, die die Kommunikation zwischen Arbeitgebern und Kandidaten automatisieren. Für Arbeitssuchende und Kandidaten bieten Chatbots eine grundlegend neue Möglichkeit, sich auf eine Stelle zu .

JobBot bringt intelligente Technologie in die Personalbeschaffung durch automatisierte und zweisprachige Chatbots.

MoBerries vereint die gesamte Rekrutierungskraft von über 250+ Unternehmen und VCs, um den richtigen Kandidaten zur richtigen Zeit zu finden.

Bild und Video

Brighter AI bietet die visuelle Rekonstruktion als Dienstleistung an. Brighter AI verbessert Bilder wie das Entfernen von Nebel und Regen oder das Entfernen von Nummernschildern und Gesichtern.

DeepVA ermöglicht eine tiefgreifende und umfassende Untersuchung von Unternehmensdaten, indem versteckte Metainformationen aus Videos & Bildern extrahiert zugänglich gemacht werden.

EyeEm ist ein Fotounternehmen, das Computer Vision Technologie entwickelt, um seine globale kreative Community mit Marken zu verbinden. Die Sammlung von EyeEm umfasst mehr als 90 Millionen Bilder von mehr als 20 Millionen Fotografen auf der ganzen Welt.

Moonvision versetzt Kunden in die Lage, Objektverfolgungslösungen in verschiedenen Branchen mit Hilfe von maschinellem Lernen zu nutzen. Ihre Lösungen können in verschiedenen Umgebungen eingesetzt werden, um Videomaterial zu analysieren und Ereignisse auszulösen.

Nyris findet Produkte und Objekte in Bildern und Videos in weniger als einer Sekunde. Seine visuelle Suchmaschine aggregiert erstklassige Algorithmen für eine unvergleichliche Matching-Geschwindigkeit und -Qualität.

Durch die Arbeit mit künstlicher Intelligenz und Bilderkennung hilft Peat Technology Landwirten weltweit, ihre Pflanzen zu schützen. Mit modernsten Technologien unterstützen sie die Sicherung jeder Ernte sowie eine sichere Nahrungsmittelproduktion.

Picalike steigert die Leistungsfähigkeit von Online-Shops und Marktplätzen. Die Darstellung personalisierter, optisch ähnlicher Artikel in Produktempfehlungen verbessert die Relevanz und erhöht die Konversionsraten, insbesondere im modischen und möbelbezogenen E-Commerce.

pikd verbindet Forschung mit jahrelanger praktischer Erfahrung in der Entwicklung von Automatisierungslösungen und modernster Computing-Infrastruktur.

Planet-AI ist ein wissenschaftlich und F&E-getriebenes Softwareunternehmen und bringt Software-Toolkits (SDK) auf den Markt, die einfach in End-to-End-Partneranwendungen oder Betriebssysteme integriert werden können.

RAYPACK.Ai entwickelt AI-Lösungen für Visual Computing in den Bereichen object detection, video analysis, face- und pose recognition.

TwentyBN entwickelt Systeme die Videos verstehen. Es arbeiten mit Kunden aus Branchen wie Smart Home oder Automotive zusammen, um die Leistung von Videoanwendungen zur Aktivitätserkennung und Mensch-Maschine-Interaktion zu verbessern.

Industry 4.0

Actyx löst technische Probleme und arbeitet ständig an der Vision einer intelligenten, adaptiven, nachhaltigen und effizienten Fertigung.

Arago baut Lösungen um Enterprise IT und Business Operations zu automatisieren, basierend auf Machine Learning Verfahren.

Anacode wird von einem Team von Fachleuten aus den Bereichen Deep Learning, NLP und International Business geleitet. Sie entwickeln Analyselösungen, die Unternehmen helfen, ihre Zielmärkte unabhängig und unvoreingenommen zu verstehen.

Connective Elements ist ein Unternehmen der Robotic Process Automation für Innovationsmanagement und strategische Geschäftsentwicklung. Sie bieten eine verbesserte Kosteneffizienz durch effizientere Nutzung von Ressourcen (Server, Speicher, Netzwerk, etc.) und reduzierte Lizenzkosten.

Cogista bietet Lösungen für Betriebsstrategie und -konfiguration, Produktion, Supply Chain Management, vorausschauende Instandhaltung und Produktions-/Qualitätskontrolle. Die Lösungen von Cogista decken strategische, taktische und operative Herausforderungen ab, während ihre Lösungen einen schnellen Start und eine industrielle Standardisierung ermöglichen.

Evertracker ist eine Plattformtechnologie, die lückenlose Echtzeit-Positionsdaten über angeschlossene Geräte wie GPS, Bluetooth, RFID oder andere sammelt. Es analysiert sie in Echtzeit, vergleicht sie mit historischen Informationen und korreliert sie mit vorhandenen Quellen wie Verkehr oder Wetter.

INNOPLEXUS unterstützt Unternehmen bei der kontinuierlichen Entscheidungsfindung, indem es breitere, tiefere und schnellere Einblicke aus strukturierten und unstrukturierten privaten und öffentlichen Daten mit Hilfe modernster, patentierter künstlicher Intelligenz, Blockchain und fortschrittlicher Analyse-Technologien generiert.

Die Integrana GmbH entwickelt KIs im Kundenauftrag und berät die Kunden umfassend zu den Themengebieten Machine Learning, KI, DataScience und Business Intelligence und unterstützt bei der Umsetzung.

Kahaura ermöglicht es Unternehmen, KI-Lösungen entsprechend ihren Anforderungen zu entwickeln und zu implementieren. Sie sind spezialisiert auf AI, IT-Consulting und Software-Entwicklung.

KI-Group hilft Unternehmen, das Geschäft der Zukunft aufzubauen. KI Group glaubt an Spitzentechnologien und vertraut auf die Kraft motivierter, aufgeschlossener Menschen mit technischem und unternehmerischem Denken.

Die Konux-Technologie nutzt Künstliche Intelligenz, um Kunden dabei zu unterstützen, ihre Infrastruktur kontinuierlich zu überwachen und ihre Betriebsabläufe zu verbessern. Die durchgängige Sensordatenlösung versetzt Industrie- und Bahnunternehmen in die Lage, eine neue Dimension der Anlagenperformance zu erreichen.

micropsi industries nutzt Reinforcement Learning, um dynamisches, sensorgesteuertes Verhalten für Industrieroboter zu generieren. micropsi industries bietet eine dritte Option für Verhaltensweisen, die sich dynamisch an die Umgebung anpassen müssen, angetrieben von Kamerabildern oder Kraftsensoren.

Die Kernplattform von Neokami wurde optimiert, um eine fokussierte Reihe der drängenden Datensicherheitsprobleme von heute zu lösen. Das Produkt ermöglicht es Unternehmen, sensible Daten in der Cloud, vor Ort oder über ihre physischen Ressourcen hinweg aufzuspüren, zu klassifizieren und zu schützen.

Die Plattform von Njoin analysiert Daten der machine-to-machine Kommunikation in Echtzeit und bietet leistungsfähige Tools um Manager und Ingenieure bei der Planung zu unterstützen.

Die proprietären Techniken des maschinellen Lernens ermöglichen es Unternehmen, ihre CAE-Workflows einfach zu automatisieren und über einfache, leicht zu bedienende Schnittstellen auf sie zuzugreifen.

Sota-Lösungen lassen Visionen und Technologievorsprung Wirklichkeit werden. Sie nutzt die Datenflut des Unternehmens, um die wichtigsten Prozesse zu simulieren, zu gestalten und zu verbessern.

Tngtech unterstützt seine Kunden mit modernsten Werkzeugen und innovativen Ideen. Ihre Aufgabe ist es, die strategischen oder routinemäßigen IT-Probleme der Kunden zu analysieren und zu lösen.

True Physics zielt darauf ab, Prozesse zu unterstützen, die in hohem Maße von Daten abhängig sind, die zur Laufzeit generiert werden oder einen hohen Anteil mechanischer Wechselwirkungen zwischen Werkstücken, Werkzeugen und Robotern aufweisen.

thingsTHINKING unterscheidet sich von bekannten Ansätzen in NLP/NLU, da es die Bedeutung von Begriffen (aka Semantik) der natürlichen Sprache analysiert. Deshalb führt thingsTHINKING wie ein menschlicher Agent umfassende und präzise Analysen durch.

Theum fasst komplexe Dokumentenpools zu leistungsfähigen, virtuellen Themenexperten zusammen, die mit Hilfe von KI klare, vollständige und gebrauchsfertige Antworten auf jede Frage liefern.

Unified Inbox entwickelt und betreibt eine intelligente Internet of Things (IoT) Messaging-Plattform namens Unification Engine (UE).

Xamla konzentriert sich auf die adaptive Robotik mit Hilfe von KI-Prozessen. Ziel ist es, gemeinsam mit der weltweiten Robotik-Community die Ära der Personal-Roboter einzuläuten. Roboter lernen, die Komposition einer Szene zu sehen, zu fühlen und zu verstehen, und ermöglichen die Programmierung von intelligentem Roboterverhalten.

Infotainment

149 Technologies konzentriert sich darauf, die proprietäre Kontext-Engine mit der Technologie des maschinellen Lernens zu kombinieren, so dass der persönliche Kalender jeden Tag ein wenig hilfreicher wird - so können Sie Aufgaben schneller erledigen und leicht auf Informationen zugreifen, die für verschiedene Ereignisse relevant sind, und das alles an einem einzigen Ort.

Ziel von Aivy ist es, ein tieferes Verständnis der intrinsischen Motivation hinter den Handlungen des Benutzers zu erlangen, indem Muster in Faktoren gefunden werden, die unser tägliches Leben beeinflussen und Handlungen bestimmen.

gigaaa ist ein persönlicher Assistent sowie ein Chat-Messenger. Die Mission von gigaaa ist es, die Organisation Ihrer Freizeit und der damit verbundenen Aktivitäten so einfach wie möglich zu gestalten.

Sensape entwickelt künstliche Wahrnehmung für Infotainmentsysteme. Sie bieten die Technologie zur Interaktion mit Schaufenstern oder Shop-Applikationen.

TAWNY hat sich Emotion AI verschrieben und will Systeme bauen in der sich intelligente Dinge an menschliche Emotionen anpassen, um effizienter, komfortabler, gesünder und sicherer zu sein.

Infrastruktur

RiseML fügt Unterstützung für Machine Learning Workloads und Frameworks wie TensorFlow hinzu. Mit RiseML können Sie auf einfache Weise Experimente verfolgen, verteilte Lernexperimente über mehrere Knoten hinweg durchführen und Hyperparameter-Optimierung durchführen.

Understand.ai bietet hochwertige Bildkommentare für autonomes Fahren, Satellitenbilder und Medizin.

Retail & e-commerce

Blue Yonder bietet seinen Kunden prädiktive Analyselösungen für optimale Entscheidungsfindung - automatisiert und in Echtzeit.

Cartwatch ist ein Start-up-Unternehmen, das Lösungen für die Warensicherung und den Diebstahlschutz entwickelt, die auf der neuesten Technologie in den Bereichen Computer Vision und Deep-Learning basieren.

EyeQuant hilft Unternehmen, usability optimiert Websites zu entwerfen. EyeQuant-optimierte Websites bieten ein viel besseres Benutzererlebnis und erzielen deutlich höhere Konversionsraten.

Fedger verwendet fortschrittliche Algorithmen und maschinelle Intelligenz, um Webdaten zu sammeln, zu strukturieren, anzureichern und zu kontextualisieren und sie über einfach zu bedienende Micro-Apis in kurzer Zeit zugänglich zu machen.

Die Experten von SO1 haben eine händlerübergreifende Promotion-Plattform aufgebaut, die auf modernsten Algorithmen und einer nahtlosen (Offline-) Retail-Integration basiert. Auf dieser Plattform sind sowohl Marken als auch Händler in der Lage, Konsumenten individuell und in Echtzeit anzusprechen.

Wunderai entwickelt kognitive KI-Anwendungen in Echtzeit, um Marken dabei zu unterstützen, näher an die Kunden heranzukommen und durch höhere Marketingeffektivität zu wachsen.

Sales & Marketing

Alexjacobi ist ein KI-Unternehmen, das Algorithmen entwickelt, um Daten als Kernstück kreativer Ideen zu nutzen, nicht um sie zu rechtfertigen. Und sie nutzt sie, um audiovisuelle Kommunikation zu schaffen, die für jeden Menschen relevant, respektvoll und authentisch ist.

Die Adtelligence Personalization Cloud, eine SaaS-Lösung, optimiert das Benutzererlebnis von E-Commerce-Shops, mobilen Websites und Online-Portalen durch die Nutzung großer Datenmengen und maschinelles Lernen.

Basierend auf Machine Learning prognostiziert der B2B-Service von goedle.io die Abwanderung von Nutzern in Freemium-Applikationen und nutzt diese Informationen, um die Nutzer durch Re-Targeting zu binden.

Inbot hilft innovativen B2B-Unternehmen dabei, potentielle Kunden weltweit kennenzulernen. Es unterstützt Wachstum der B2B-Verkäufe von Unternehmen auf der ganzen Welt.

Schnelle Marktforschung auf Basis von Neuro-Science und Big-Data. Sie testen visuelles und verbales Marketingmaterial in der Zielgruppe und liefern zuverlässige Ergebnisse innerhalb weniger Tage.

Qymatix Solutions hat sich auf den Bereich der prädiktiven Verkaufsanalyse für B2B mit Hilfe von Künstlicher Intelligenz spezialisiert. Qymatix entwickelt und vermarktet eine SaaS-Lösung, die es Vertriebsleitern in mittelständischen Business-to-Business-Unternehmen ermöglicht, durch bessere Marketing-Entscheidungen eine wesentlich höhere Geschäftserfolgsrate zu erzielen.

Saas.co entwickelt LISA, einen Assistenten für Verkauf und Kundenbetreuung, der E-Mails liest, versteht, kategorisiert und entwirft.

Software Development

Acellere hat eine intelligente Software-Analyse-Plattform namens Gamma entwickelt, als Teil ihrer Mission, eine globale Bewegung für sauberen Code zu starten.

Deckard Intelligence ist die KI-Engine, die über die Struktur und Leistung eines Softwareentwicklungsteams lernt und Hunderte von Stunden unpräziser menschlicher Arbeit durch zuverlässige und objektive Schätzungen, Warnungen und Benchmarks ersetzt.

Lateral nutzt maschinelles Lernen, um das Problem der Auffindbarkeit zu lösen, und es hilft Unternehmen dabei, ihr internes Wissen sowie hochwertige externe Quellen zu nutzen, so dass die Mitarbeiter leicht die relevanten Fachkenntnisse und Dokumente finden können, die sie für ihre Arbeit benötigen.

Text & Document

Ambiverse entwickelt Technologien zum automatischen Verstehen, Analysieren und Verwalten von Big Text-Sammlungen. Ambiverse basiert auf jahrelanger Forschung auf dem neuesten Stand der Technik in der Textanalytik.

Leverton entwickelt und wendet disruptive Deep-Learning-Technologien an, um Daten aus Unternehmensdokumenten in mehr als 20 Sprachen zu extrahieren, zu strukturieren und zu verwalten.

SearchInk ist ein Unternehmen für Maschinenintelligenz, das, strukturierte Daten aus beliebigen Dokumenten zu extraextrahiert.

Smacc ist eine Software, die die Buchhaltung und die damit verbundenen Finanzprozesse digitalisiert und automatisiert. Sie bietet Unternehmen einen ständigen, aktuellen Zugriff auf betriebswirtschaftliche Daten und Analysen.

synergist.io wird von Einkaufsabteilungen, kaufmännischen Teams und alternativen juristischen Dienstleistern genutzt, um große Mengen wiederkehrender Verträge mit minimalem Aufwand abzuwickeln.

Künstliche Intelligenz ist heute im Begriff, in allen Lebensbereichen moderner Gesellschaften Einzug zu halten. Bislang standen jedoch Anwendungsgebiete im Fokus, die wenig alltäglich sind, wie Medizin, Forschung und Hochtechnologie. Wenig später folgte die Welt der privaten Unterhaltung und Mobilität: Intelligente Assistenten in Smartphones und Autos ebenso wie in der Unterhaltungselektronik und im Web. Jetzt dringt KI auch in einen Bereich vor, der ein fester Bestandteil des Alltagslebens außer Haus ist: der tägliche Einkauf.

Das vor allem als Online-Großhändler bekannte Unternehmen Amazon geht mit dem Konzept eines intelligenten Supermarktes an den Start. In Seattle, im US-Bundesstaat Washington, eröffnete der Konzern im Januar 2018 den ersten Amazon Go Supermarket. Hier soll dem Kunden der alltägliche Einkauf, vor allem von Lebensmitteln, in neuer, vereinfachter Form geboten werden: kein Anstehen an der Kasse, kein Einscannen von Barcodes, keine Angestellten. Der Kunde betritt den Laden, nimmt Waren aus den Regalen, steckt sie ein und verlässt das Geschäft, fertig. Der fällige Betrag wird über das Amazon-Konto der Kunden abgebucht, die entnommenen Waren werden in der Lagerbuchhaltung vom Bestand abgezogen.

Das vor allem als Online-Großhändler bekannte Unternehmen Amazon geht mit dem Konzept eines intelligenten Supermarktes an den Start. In Seattle, im US-Bundesstaat Washington, eröffnete der Konzern im Januar 2018 den ersten Amazon Go Supermarket. Hier soll dem Kunden der alltägliche Einkauf, vor allem von Lebensmitteln, in neuer, vereinfachter Form geboten werden: kein Anstehen an der Kasse, kein Einscannen von Barcodes, keine Angestellten. Der Kunde betritt den Laden, nimmt Waren aus den Regalen, steckt sie ein und verlässt das Geschäft, fertig. Der fällige Betrag wird über das Amazon-Konto der Kunden abgebucht, die entnommenen Waren werden in der Lagerbuchhaltung vom Bestand abgezogen.

Was so einfach klingt, erfordert einiges an intelligenter Technologie im Hintergrund und ganz ohne Voraussetzungen funktioniert auch der Einkauf hier nicht: Kunden benötigen die (kostenlose) Amazon Go-App und melden sich beim Betreten des Ladens an, indem sie vom System einen QR-Code vom Smartphone scannen lassen. Danach allerdings kann das Telefon getrost eingesteckt werden, denn von nun an übernimmt die künstliche Intelligenz des Ladens mit ihrem lernenden Algorithmus den Ablauf. Während sie vom System per Kamera samt Personenerkennung ständig beobachtet werden, entnehmen die Kunden die Waren aus den Regalen, die ihrerseits als Waagen fungieren. Die entnommene Stückzahl einer Ware wird dem Kunden im virtuellen Warenkorb gutgeschrieben, zurückgelegte Waren werden wieder gelöscht. Ist der Einkauf beendet, registriert die KI es, wenn der Kunde das Geschäft verlässt, und belastet kurz darauf sein Amazon-Konto mit dem fälligen Betrag.

Der entscheidende technologische Fortschritt ist hierbei sicherlich die Selbstverständlichkeit, mit der der Waren- und Geldtransfer vonstattengeht. Die Kunden müssen keine Waren einscannen und der Einkauf geschieht unter ständiger optischer und sensorischer Kontrolle der KI, ohne dass Vertrauen in die Ehrlichkeit der Kunden gesetzt werden müsste. Ganz ohne Personal kommt aber auch Amazons intelligenter Supermarkt nicht aus: Mitarbeiter sorgen für den Warennachschub in den Regalen, bereiten verzehrfertige Nahrungsmittel vor und beaufsichtigen den Verkauf von Alkohol, um gesetzlichen Vorgaben zu genügen. Nicht eindeutig sind auch die Aussagen von Amazon zu der Frage, ob es sich bei dem neuen Konzept um eine Machbarkeitsstudie handelt, oder um den Prototypen einer ganzen Kette von Geschäften. Ganz allgemein ist Amazons Vorstoß wohl als Teil einer Entwicklung zu sehen, in deren Verlauf Funktionsweise und Erscheinungsbild des Lebensmittel- und Einzelhandels zunehmend verändert werden: Nach und nach verschwinden Kassen und Personal aus den Läden und der Supermarket wird – so die Vision – zum intelligenten autonomen System.

Der entscheidende technologische Fortschritt ist hierbei sicherlich die Selbstverständlichkeit, mit der der Waren- und Geldtransfer vonstattengeht. Die Kunden müssen keine Waren einscannen und der Einkauf geschieht unter ständiger optischer und sensorischer Kontrolle der KI, ohne dass Vertrauen in die Ehrlichkeit der Kunden gesetzt werden müsste. Ganz ohne Personal kommt aber auch Amazons intelligenter Supermarkt nicht aus: Mitarbeiter sorgen für den Warennachschub in den Regalen, bereiten verzehrfertige Nahrungsmittel vor und beaufsichtigen den Verkauf von Alkohol, um gesetzlichen Vorgaben zu genügen. Nicht eindeutig sind auch die Aussagen von Amazon zu der Frage, ob es sich bei dem neuen Konzept um eine Machbarkeitsstudie handelt, oder um den Prototypen einer ganzen Kette von Geschäften. Ganz allgemein ist Amazons Vorstoß wohl als Teil einer Entwicklung zu sehen, in deren Verlauf Funktionsweise und Erscheinungsbild des Lebensmittel- und Einzelhandels zunehmend verändert werden: Nach und nach verschwinden Kassen und Personal aus den Läden und der Supermarket wird – so die Vision – zum intelligenten autonomen System.

Machine Learning und künstliche neurale Netze sind schon seit einiger Zeit viel diskutierte und hochspannende Themen der aktuellen Forschung. Google ist es nun gelungen, eine künstliche Intelligenz (AI von engl. Artificial Intelligence) zu erschaffen, die ihre eigenen "Kinder", also ebenfalls künstliche Intelligenzen, hervorbringen kann. Und die sind verlässlicher und präziser als alle vergleichbaren, durch Menschen geschaffene AIs.

Was ist Machine Learning?

Machine Learning bedeutet im Grunde genau das, was das Wort vermuten lässt: Lernen, also die Generierung von Wissen aus Erfahrung. Allerdings wird das Wissen automatisiert durch ein Computersystem gewonnen. Durch die Automatisierung der Datenanalyse lassen sich große Datenmengen zur Mustererkennung schnell verarbeiten – viel schneller und genauer als es ein Mensch könnte.

Das Projekt AutoML

Auf Basis dieses Ansatzes hat Google nun eine eigene künstliche Intelligenz geschaffen, die Kinder erzeugen kann. Die AI AutoML schlägt für ihre AI Kinder bestimmte Softwarearchitekturen und Algorithmen vor. Diese werden anschließend getestet und auf Basis der Testergebnisse verbessert. Dabei wird die Methodik des Reinforcement Learning verwendet. Das bedeutet, die AI erstellt ohne Vorgaben eines Menschen einen Vorgehensplan oder eine Strategie und passt diese durch entsprechendes positives und negatives Feedback an. Zusammen mit der iterativen Verbesserung durch mehrere Zyklen werden die AI Kinder in der Ausführung ihrer Aufgaben somit immer besser.

Aufgaben der AI

Das Ziel des Google-Supercomputers ist die Erkennung von Objekten wie Menschen, Tieren oder Autos in einem Video. NASNet, wie das AI Kind heißt, ist dabei sehr erfolgreich: Es ist dazu in der Lage 82.7% der Objekte in den ihm gezeigten Videos korrekt zu erfassen. Damit ist es besser als alle AIs, die unter ähnlichen Bedingungen von Menschen implementiert wurden.

Die automatische Erkennung von Objekten, die damit gelungen ist, ist für viele Branchen von Interesse. Denn die so erzeugten Systeme sind nicht nur genauer, sie können auch deutlich komplexer sein. Erste Anwendungen finden sich zum Beispiels in selbstfahrenden Autos. Und auch andere Unternehmen werden davon profitieren, dass sie AIs für schwierige Aufgaben, beispielsweise für Operationen, schneller und präziser entwickeln können.

Der ethische Aspekt

Trotz der vielversprechenden Zukunftsaussicht müssen sich große Unternehmen, die momentan im Bereich künstlicher Intelligenz forschen, mit ethischen Fragen auseinandersetzen. Was passiert beispielsweise, wenn AutoML zu schnell AI Kinder erzeugt, als die Gesellschaft nachziehen kann? Oder was passiert, wenn die AI zu irgendeinem Punkt ein Eigenleben entwickelt? Wichtige Vorantreiber der Forschung, neben Google unter anderem auch Amazon und Facebook, beschäftigen sich daher mit der verantwortungsbewussten Erzeugung von künstlichen Intelligenzen.

Letzte Woche hatten wir einen sehr erfolgreichen Tag auf dem Digital Demo Day in Düsseldorf.

Letzte Woche hatten wir einen sehr erfolgreichen Tag auf dem Digital Demo Day in Düsseldorf.

Vor und vor allem nach unserer Präsentation hatten wir eine Menge interessanter Gespräche auf unserem Stand, auf dem wir Beispiele zum Thema Visual Computing mit AI und unsere AI-Cam gezeigt haben.

Wir haben uns sehr über viele neue Kontakte und das Treffen mit einigen Freunden aus unserem Netzwerk gefreut.

Unser großer Dank gilt Klemens Gaida und seinem Team, für die Organisation eines großartigen Events.

Die rasante Entwicklung der künstlichen Intelligenz hat in den letzten Jahren immer neue Ebenen erreicht, die wenig früher noch als reine Science-Fiction galten. Mit besonderer Aufmerksamkeit – und von verschiedenen Seiten auch mit besonders großen Befürchtungen – werden stets vor allem Neuigkeiten betrachtet, die in Richtung eines maschinellen Bewusstseins deuten. Derzeit verblüffen vor allem in dem Bereich Wahrnehmung und ihre Manipulation die von Maschinen erbrachten Leistungen Laien und sogar Fachleute in zunehmendem Maße.

Ein gutes Beispiel ist die Arbeit einer KI-Forschungsgruppe in der Entwicklungsabteilung des vor allem als Grafikkarten-Hersteller bekannten Unternehmens Nvidia. Den Forschern gelang es, einem künstlichen neuronalen Netz beizubringen, ausgehend von Bild- und Filmquellen diese Medien hinsichtlich bestimmter Charakteristika auf glaubwürdige Weise zu verändern. So ist es mit dieser Technologie möglich, das Wetter in einem Video zu ändern oder die Rasse eines Hundes auf einem Bild. Der entscheidende Punkt hierbei ist, dass Darstellungen in Bild- oder Videoform fast beliebig manipulierbar werden, ohne dass ein menschlicher Editor eingreifen muss. Die Ergebnisse sind bislang noch nicht perfekt, dürften aber in Zukunft noch wesentlich überzeugender werden.

Ein gutes Beispiel ist die Arbeit einer KI-Forschungsgruppe in der Entwicklungsabteilung des vor allem als Grafikkarten-Hersteller bekannten Unternehmens Nvidia. Den Forschern gelang es, einem künstlichen neuronalen Netz beizubringen, ausgehend von Bild- und Filmquellen diese Medien hinsichtlich bestimmter Charakteristika auf glaubwürdige Weise zu verändern. So ist es mit dieser Technologie möglich, das Wetter in einem Video zu ändern oder die Rasse eines Hundes auf einem Bild. Der entscheidende Punkt hierbei ist, dass Darstellungen in Bild- oder Videoform fast beliebig manipulierbar werden, ohne dass ein menschlicher Editor eingreifen muss. Die Ergebnisse sind bislang noch nicht perfekt, dürften aber in Zukunft noch wesentlich überzeugender werden.

Noch einen Schritt weiter gingen nun Wissenschaftler der Universität Kyoto: Sie wandten ein ähnliches Verfahren an, um eine künstliche Intelligenz die inneren Wahrnehmungsbilder im menschlichen Gehirn erkennen zu lassen.Die KI liest also gewissermaßen die Gedanken einer Person. Im Einzelnen passiert dabei dies: Ein neuronales Netz wird darauf trainiert, Bilder, die eine menschliche Versuchsperson ansieht, abzugleichen mit durch fMRT (funktionelle Magnetresonanztomographie) gewonnenen Daten der korrespondierenden Gehirnaktivität der Person. Auf diese Weise lernt die KI, externe Stimuli (die Bilder) mit den internen Zuständen im Gehirn (den MRT-Mustern) zu assoziieren. Erhält sie nach dieser Lernphase als Input nur noch MRT-Daten, ist sie in der Lage, das vom Menschen Wahrgenommene daraus zu rekonstruieren, ohne zuvor selbst Kenntnis von diesen Bildern genommen zu haben. Die dabei von der KI produzierten Abbilder dieser geistigen Vorgänge sind bislang alles andere als fotorealistisch, lassen aber das Ursprungsbild eindeutig wiedererkennen.

Eine auf den ersten Blick so bedrohlich wirkende Schlagzeile wie KI liest Ihre Gedanken sollte bei genauerem Hinsehen also nicht mehr soviel Unbehagen erzeugen. Das eigentliche „Gedankenlesen“, den Blick ins Gehirn, übernimmt weiterhin das MRT, und dafür ist es ja auch gedacht. Die künstliche Intelligenz dagegen beschränkt sich auf Mustererkennung durch ein neuronales Netz und die Anwendung des Gelernten auf neue Daten. Dabei liegt die Stärke neuronaler Netze in der Arbeitsgeschwindigkeit: Während Menschen Stunden benötigen, um neue Lektionen zu lernen, kann ein solches System Millionen von Lernvorgängen in der gleichen Zeit absolvieren. Die große Zahl an Durchgängen erzeugt im Netz ein sehr differenziertes System von Gewichtungen und Zuständen zwischen den Neuronen, sodass das Resultat mit andauerndem Training dem Vorbild immer ähnlicher wird. Die denkbaren Anwendungen sind vielfältig, aber vor allem in einer Hinsicht bietet diese Technologie faszinierende Verheißungen für die Zukunft: So könnte es Menschen, die nicht sprachlich oder schriftlich kommunizieren können, ermöglicht werden, ihre Gedanken und inneren Bilder mitzuteilen. Auch noch weiterreichende Anwendungen sind denkbar, etwa das direkte „Hochladen“ von geistigen Inhalten in Computernetzwerke.

Eine auf den ersten Blick so bedrohlich wirkende Schlagzeile wie KI liest Ihre Gedanken sollte bei genauerem Hinsehen also nicht mehr soviel Unbehagen erzeugen. Das eigentliche „Gedankenlesen“, den Blick ins Gehirn, übernimmt weiterhin das MRT, und dafür ist es ja auch gedacht. Die künstliche Intelligenz dagegen beschränkt sich auf Mustererkennung durch ein neuronales Netz und die Anwendung des Gelernten auf neue Daten. Dabei liegt die Stärke neuronaler Netze in der Arbeitsgeschwindigkeit: Während Menschen Stunden benötigen, um neue Lektionen zu lernen, kann ein solches System Millionen von Lernvorgängen in der gleichen Zeit absolvieren. Die große Zahl an Durchgängen erzeugt im Netz ein sehr differenziertes System von Gewichtungen und Zuständen zwischen den Neuronen, sodass das Resultat mit andauerndem Training dem Vorbild immer ähnlicher wird. Die denkbaren Anwendungen sind vielfältig, aber vor allem in einer Hinsicht bietet diese Technologie faszinierende Verheißungen für die Zukunft: So könnte es Menschen, die nicht sprachlich oder schriftlich kommunizieren können, ermöglicht werden, ihre Gedanken und inneren Bilder mitzuteilen. Auch noch weiterreichende Anwendungen sind denkbar, etwa das direkte „Hochladen“ von geistigen Inhalten in Computernetzwerke.

Der Digital Demo Day steht vor der Tür, und wir freuen uns, daran teilzuhaben! Am 1. Februar präsentieren wir Ihnen unsere digitalen Lösungen und unsere innovativen AI-Technologien im Digital Hub in Düsseldorf.

Besuchen Sie uns auf dem Digital Demo Day, um die neuesten digitalen Trends kennenzulernen, über Anwendungsmöglichkeiten zu sprechen und tiefgehende Einblicke zu erhalten.

Tickets erhalten Sie hier

Wir sehen uns dort!

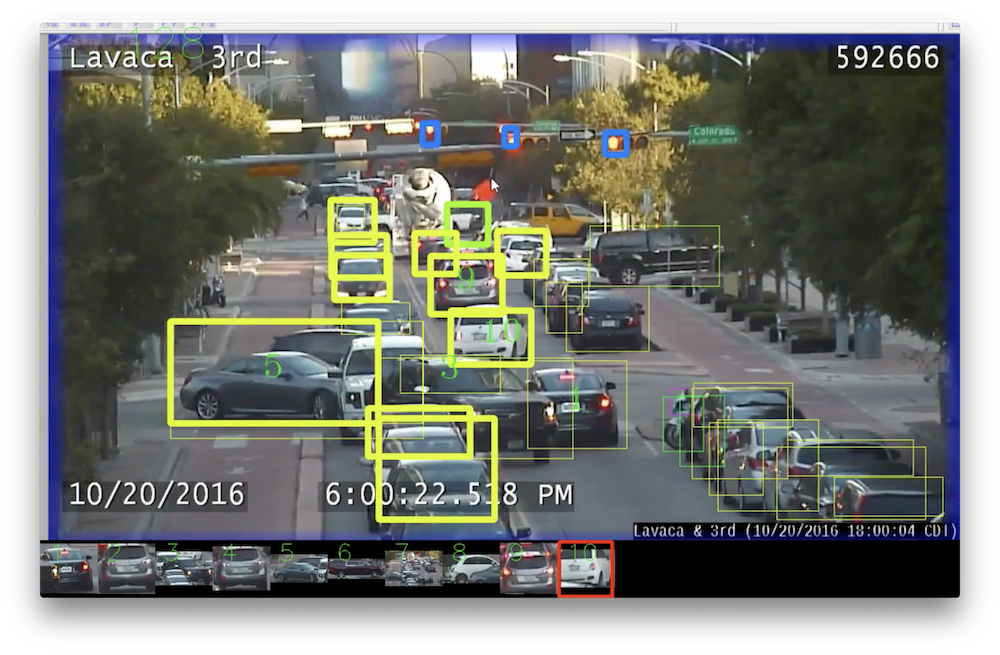

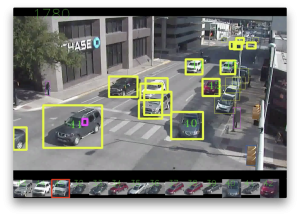

Kameras an Straßenkreuzungen und anderen vielbefahrenen Straßen sind keine Neuerung. Sie ermöglichen die Überwachung des Verkehrsgeschehens und liefern Bilder im Falle von Unfällen. In Zukunft könnten die Aufnahmen der Kameras noch wertvollere Dienste leisten – mithilfe der Künstlichen Intelligenz. Die Auswertung von Verkehrsdaten durch Supercomputers könnte bald dafür sorgen, dass die Straßen sicherer werden. Indem sie in kurzer Zeit Daten auswerten und den Verkehr analysieren. Wissenschaftler vom Texas Advanced Computing Center (TACC), dem Center for Transportation Research der Universität von Texas und die texanische Stadt Austin arbeiten an Programmen, die mittels Deep Learning und Data Mining die Straßen sicherer machen und Verkehrsprobleme beseitigen.

Die Wissenschaftler entwickeln eine Künstliche Intelligenz, die durch Deep Learning die Videoaufnahmen von Verkehrspunkten auswertet. Diese Software soll in der Lage sein, Objekte zu erkennen und richtig einzuordnen. Bei den Objekten handelt es sich um Autos, Busse, Lastwagen, Motorräder und um Ampeln und Menschen. Die Software ermittelt, wie sich diese Objekte bewegen und verhalten. Dadurch lassen sich Informationen gewinnen, die wiederum genauer analysiert werden können, um Verkehrsproblemen vorzubeugen. Das Ziel ist es, eine Software zu entwickeln, welche Verkehrsforscher bei der Auswertung von Daten zu helfen. Die Künstliche Intelligenz soll dabei flexibel einsetzbar sein und auch in Zukunft Verkehrsprobleme aller Art erkennen können, ohne dass sie jemand speziell dafür programmieren muss.

Dank des Deep Learnings ordnen die Supercomputers die Objekte richtig zu und schätzen zwischen den ermittelten Objekten die Verhältnisse im Straßenverkehr ein, indem sie den Bewegungen der Autos, Menschen etc. folgt. Nachdem diese Arbeit getan war, gaben die Wissenschaftler der Software zwei Aufgaben: Die Anzahl der Fahrzeuge zu zählen, welche eine Straße entlang fuhren. Und schwieriger: Beinahezusammenstöße zwischen Fahrzeugen und Fußgänger festhalten. Die Künstliche Intelligenz wertete Videomaterial von 10 Minuten aus und zählte mit zu 95%iger Sicherheit alle Fahrzeuge. Das Verkehrsaufkommen genau bestimmen zu können ist eine wertvolle Fähigkeit des Supercomputers. Zurzeit sind noch zahlreiche teure Sensoren nötig, um solche Daten zu gewinnen oder Studien müssen durchgeführt werden, die jeweils nur spezifische Daten erbringen würden. Die Software hingegen kann das Verkehrsvolumen über einen weiten Zeitraum beobachten und so Zahlen über das Verkehrsaufkommen liefern, die weitaus genauer sind. Dadurch lassen sich bessere Entscheidungen über die Gestaltung des Straßenverkehrs treffen. Im Falle der Beinahezusammenstöße konnten die Wissenschaftler dank der Künstlichen Intelligenz automatisch Situationen erkennen, in denen Fußgänger und Fahrzeuge sich bedrohlich nahe kamen. Dadurch können Verkehrspunkte, die besonders gefährlich sind, schon identifiziert werden, bevor Unfälle erst geschehen. Die analysierten Daten könnten sich als sehr aufschlussreich erweisen, wenn es darum geht, zukünftige Verkehrsprobleme aus dem Weg zu räumen.

Das nächste Projekt: Die Software soll lernen, an welchen Stellen Fußgänger die Straße überqueren, wie die Fahrer auf Schilder reagieren, die sie auf die Straße überquerende Fußgänger hinweisen und sie soll herausfinden, wie weit die Fußgänger bereit sind zu laufen, um den Fußgängerweg zu erreichen. Das Projekt der Texas Advanced Computing Center und der Universität von Texas verdeutlicht, wie Deep Learning dabei helfen kann, den Aufwand der Analyse von Videomaterial zu reduzieren.

Das nächste Projekt: Die Software soll lernen, an welchen Stellen Fußgänger die Straße überqueren, wie die Fahrer auf Schilder reagieren, die sie auf die Straße überquerende Fußgänger hinweisen und sie soll herausfinden, wie weit die Fußgänger bereit sind zu laufen, um den Fußgängerweg zu erreichen. Das Projekt der Texas Advanced Computing Center und der Universität von Texas verdeutlicht, wie Deep Learning dabei helfen kann, den Aufwand der Analyse von Videomaterial zu reduzieren.

Am 15 und 16. März wird in München die erste und bereits anerkannte Handelsblatt Konferenz zur künstlichen Intelligenz stattfinden.

Wir haben intensiv bei der Organisation mitgeholfen und sind stolz darauf, dass wir ein tolles Programm mit erstklassigen Referenten zusammenstellen konnten

Freuen Sie sich unter anderem auf Damian Borth, Annika Schröder, Klaus Bauer, Norbert Gaus, Bernd Heinrichs, Andreas Klug, Dietmar Harhoff, Alexander Löser, Gesa Schöning, Oliver Gluth, Reiner Kraft, Thomas Jarzombek und Daniel Saaristo.

Das Highlight ist die Keynote von Prof. Jürgen Schmidhuber, einer der wichtigsten KI Forscher und der Erfinder der LSTMs, die die Basis von jeder Übersetzungs- und Speech-to Text Applikation (wie z.B. Alexa ) sind

Kommen Sie nach München, erleben Sie spannende Vortrage und diskutieren Sie mit uns über die neuesten Entwicklungen.

Wir sehen uns in München!

Jörg Bienert

Bot beim Lesen erstmals besser als ein Mensch

Die international konkurrierenden KI-Entwickler ließen von ihnen entwickelte spezifische Programme, die lesen können, zum Squad-Test antreten. Damit demonstrierten sie, wie es um die Weiterentwicklung von Lernen und Sprachverstehen der Maschinen bestellt ist. Fast alle globalen Technologieunternehmen, darunter Google, Facebook, IBM und Microsoft, verwenden den renommierten Lese- und Verständnistest Stanford Question Answering Dataset, um sich miteinander und im Vergleich mit einer durchschnittlichen menschlichen Testperson zu messen. Squad umfasst dazu mehr als 100 000 Fragen, die sich auf den Inhalt von über 500 Wikipediaartikeln beziehen. Squad stellt Fragen mit objektivierbaren Antworten wie zum Beispiel „Wodurch kommt es zu Regen?“. Andere Fragen, die beantwortet werden mussten, waren beispielsweise: „Welche Nationalität hatte Nikola Tesla?“ oder „Wie groß ist der Regenwald?“ oder „Welche Musikgruppe trat in der Super Bowl 50 Halbzeitshow auf?“ Ergebnis: Der Bot besteht. Und nicht nur das. Er war erstmals besser als der Mensch.

Machine Learning Entwicklung

Die offiziell erste KI-Lesemaschine, die es geschafft hat, beim„ Squad“ besser abzuschneiden als ein Mensch ist der neue Software-Agent der Alibaba Group Holding Ltd., der im chinesischen Hangzhou vom firmeneigenen Institute of Data Science and Technologies entwickelt wurde. Die Forschungsabteilung des chinesischen e-Commerce-Riesen teilte mit, dass das maschinelle Sprachverarbeitungsprogramm ein Testergebnis von 82,44 Punkten erreichen konnte. Damit hat er den bislang geltenden Rekord von 82,30 Punkten geknackt, der noch von einem Menschen gehalten wurde. Der chinesische e-Commerce Gigant Alibaba meldet damit weiter seine führende Rolle in der Entwicklung von Technologien zum Lernen von Maschinen und der Künstlichen Intelligenz an. Allerdings ist Microsoft Alibaba dicht auf den Fersen. Microsofts Lesemaschine wurde nur knapp vom Testergebnis des Alibaba Programms übertroffen.

Die offiziell erste KI-Lesemaschine, die es geschafft hat, beim„ Squad“ besser abzuschneiden als ein Mensch ist der neue Software-Agent der Alibaba Group Holding Ltd., der im chinesischen Hangzhou vom firmeneigenen Institute of Data Science and Technologies entwickelt wurde. Die Forschungsabteilung des chinesischen e-Commerce-Riesen teilte mit, dass das maschinelle Sprachverarbeitungsprogramm ein Testergebnis von 82,44 Punkten erreichen konnte. Damit hat er den bislang geltenden Rekord von 82,30 Punkten geknackt, der noch von einem Menschen gehalten wurde. Der chinesische e-Commerce Gigant Alibaba meldet damit weiter seine führende Rolle in der Entwicklung von Technologien zum Lernen von Maschinen und der Künstlichen Intelligenz an. Allerdings ist Microsoft Alibaba dicht auf den Fersen. Microsofts Lesemaschine wurde nur knapp vom Testergebnis des Alibaba Programms übertroffen.

Was Bots besser macht

Um eine von Squad gestellte Frage zu beantworten, ist es notwendig, dass das Botprogramm präzise eine Vielzahl verfügbarer Informationen filtern kann, um dann richtige und einzig relevante Antwort zu geben. Das Programm, das das menschliche Gehirn als neurales Netzwerkmodell abbildet, arbeitet sich über Absätze zu Sätzen und von da zu Wörtern vor und versucht, Abschnitte zu identifizieren, die möglicherweise die gesuchte Antwort enthalten könnten.

Der Entwicklungschef für Programme für Künstliche Intelligenz und Sprache, Si Luo, teilte mit, das Ergebnis mache deutlich, dass Maschinen objektiv zu beantwortende Fragen nun mit hoher Genauigkeit beantworten könnten.

Das eröffne neue Möglichkeiten für die Künstliche Intelligenz und ihren Einsatz im Kundendienst. Da lesende Roboter in Zukunft auch beispielsweise medizinischen Anfragen über das Internet beantworten könnten, werde das den Bedarf an menschlichem Input stark verringern. Ein von Alibaba genutztes Botprogramm namens „Xiaomi“ beruht auf den Fähigkeiten der lesenden KI-Maschine und wurde bereits erfolgreich eingesetzt. Beim sogenannten Single´s Day, dem jährlich wiederkehrenden, größten Shoppingereignis Asiens am 11. November kam die Software erfolgreich zum Einsatz.

Der Vorteil der Bots: Sie können rund um die Uhr im Einsatz sein, merken sich alle Ergebnisse von relevanten Anfragen aus der Vergangenheit und können auf sie jederzeit zur Beratung des Kundenanliegens zurückgreifen. Während ein Kundenberater im Schnitt 230 Kundenanfragen am Tag bearbeite, habe „Xiaomi“ täglich 3,5 Millionen Anfragen bearbeiten können.

KI weiter vor bestehender Herausforderung

KI weiter vor bestehender Herausforderung

Immer noch haben Bots allerdings Schwierigkeiten mit sprachlichen Anfragen, die vage oder umgangssprachlich, ironisch oder schlichtweg grammatikalisch falsch sind. Wenn keine vorbereiteten Antworten vorliegen, ist es dem Roboterprogramm auch nicht möglich, beim Lesen eine passende Antwort zu finden. Dann reagiert es nicht adäquat und antwortet falsch.