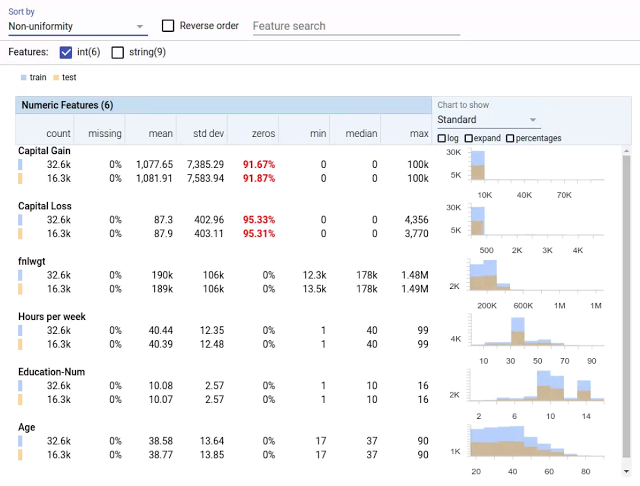

Google hat eine neues Open Source Tool Names „Facets“ zu Visualisierung von Datensets für Machine Learning veröffentlicht. (https://research.googleblog.com/2017/07/facets-open-source-visualization-tool.html)

Mit diesem sollen Nutzer ein schnelles Verständnis für die Verteilungen im Datensatz bekommen. Das Tool ist in Polymer und Rypescript erstellt und unterstützt die Einbettung in Jupyter Notebooks und auf Webseiten. Wir von der aiso-lab untersuchen derzeit, ob sich die Technology auch zur Visualisierung innerhalb einiger unserer Produkte anbietet.

Quelle: Google

Das Team der Network Security Lab der University of Washington hat eine vermeintliche Schwäche von Deep-Neural-Networks entdeckt (https://arxiv.org/pdf/1703.06857v1.pdf). DNN scheinen Probleme damit zu haben negative Bilder zu identifizieren.

Wenn das Netzwerk darauf trainiert wurde, die drei in weiß zu erkennen, lernte es nicht auch eine schwarze drei zu erkennen. Die Forscher sehen hier eine Schwäche in der Fähigkeit der DNN zu generalisieren. Eine einfache Lösung für dieses Problem wäre es, die negativ Beispiele für das Training automatisiert zu erstellen.

Außerdem stellt sich die Frage, in wie weit eine Generalisierung des Netzwerkes überhaupt gewünscht ist. Bei farbigen Bildern sollte das Netzwerk die Farbinformation nicht ignorieren. Das Netzwerk sollte eine allgemeine Betrachtung z.B. der Farbe Rot erlernen, aber trotzdem in der Lage sein Rot und Grün zu unterscheiden. Hier zeigt sich wie wichtig die sorgfältige Auswahl des Trainingssetz und der Lernfunktion sind um das Netz korrekt auf die eigenen Bedürfnisse zu trainieren.

Yoshua Bengio, einer der weltweit führenden AI-Professoren von der Université de Montréal hat in seiner aktuellsten Forschungs-Arbeit eine Verbindung zwischen Deep Learning und dem Konzept des Bewusstseins hergestellt. https://arxiv.org/pdf/1709.08568.pdf

Bengio ließ sich von der Überlegung, des „Consciousness Prior“ (in etwa „vorheriges Bewusstsein“ ) inspirieren. Durch die Kombination einiger weniger Konzepte wird ein bewusster Gedanke gebildet. Das Bewusstsein ist geprägt durch die persönliche Wahrnehmung zu einem bestimmten Zeitpunkt.

Seine Idee ist, dass die von einem Recurrent Neural Network (RNN) erzeugten „Zwischenergebnisse“ sowohl für die Erklärung der Vergangenheit als auch für die Planung der Zukunft genutzt werden können. Das System handelt daher nicht direkt auf Basis von Eingangssignalen, wie Bildern oder Texten, sondern steuert das „Bewusstsein“ aus den hieraus abstrahierten Informationen.

Der Consciousness Prior könnte dafür genutzt werden um die Informationen innerhalb trainierten neuronalen Netzwerkes wieder in natürliche Sprache oder in klassische AI-Verfahren mit Regeln und Fakten zu übersetzen. Eine Implementierung dieses Konzepts wird in dem Dokument nicht vorgestellt, jedoch schlägt Bengio vor, den Ansatz in reinforcement learning Systeme zu integrieren..

Bengios Überlegungen zeigen neue Wege für AI auf. Die Zeit wird Zeigen ob es sicher hierbei um eine revolutionäre Idee handelt, oder nur um ein „visonäres“ Gedankenspiel.

Laden Sie sich jetzt das aiso-lab Artificial Intelligence Poster kostenlos als PDF herunter.

Neue Imagenet Ergebnisse sind veröffentlicht. Ein Team aus Beijing stellt einen neuen top-5 Klassifizierungsrecord mit einer Fehler-Rate von 2,25 % auf. Die großen Firmen wie Google, Microsoft und Facebook habe in diesem wie auch schon im letzten Jahr nicht mehr teilgenommen.

In einer neuen Veröffentlichung von Google mit den Titel “Revisiting Unreasonable Effectiveness of Data in Deep Learning Era" beschreibt Google ihre Erkenntnisse, welche Sie gewonnen haben indem sie ein Neuronales Netz auf einen Bilderdatensatz mit 300x mal mehr Bildern als in ImageNet trainiert haben.

Sie kommen dabei zu dem Ergebnis, dass selbst bei einer Steigerung von 3 Million auf 300 Millionen Trainingsbeispielen die Leistung des Netzwerkes linear skaliert. Auch nach 300 Million Bildern konnte keine Abflachung der Lernkurve festgestellt werden.

Das trainierte Netz stellt dann auch sogleich einen Rekord in dem COCO object detection benchmark auf. Zu diesem Ergebnis kommen sie alleine durch die erhöhte Anzahl von Trainingsdaten, es sind keine Verbesserungen am Model selber Vorgenommen wurden.

Hier zeigt sich eindrucksvoll die Bedeutung von BigData im Zusammenhang mit Deep-Learning. Die besten Modelle können nur diese Firmen entwickeln, die über die Expertise verfügen enorme Mengen an Daten zu speichern und effizient zu verarbeiten.

Die aiso-lab steht Ihnen hier als kompetenter Ansprechpartner für alle Herausforderungen in Bereich Software und Hardware zur Verfügung.

Anfang des Jahres veranstaltete Google einen Wettbewerb auf Kaggle für YouTube Video Klassifizierung. Google stellte hierfür 7 Million Video mit insgesamt 450.000 Stunden bereit, welche in 4716 Kategorien klassifiziert werden sollten. Das drittplatzierte Team, ein Zusammenschluss von Forschern der Tsinghua Universität und Baidu, haben Ihren Ansatz kürzlich Veröffentlicht.

Sie erreichen mit einer 7 Layer tiefen LSTM Architektur eine Genauigkeit von 82,75 % nach der verwendeten Global Average Precision Metrik.

Die verwendete Architektur des temporal residual CNN, ist wie folgend Dargestellt:

Quelle: Tsinghua Universität, 2017

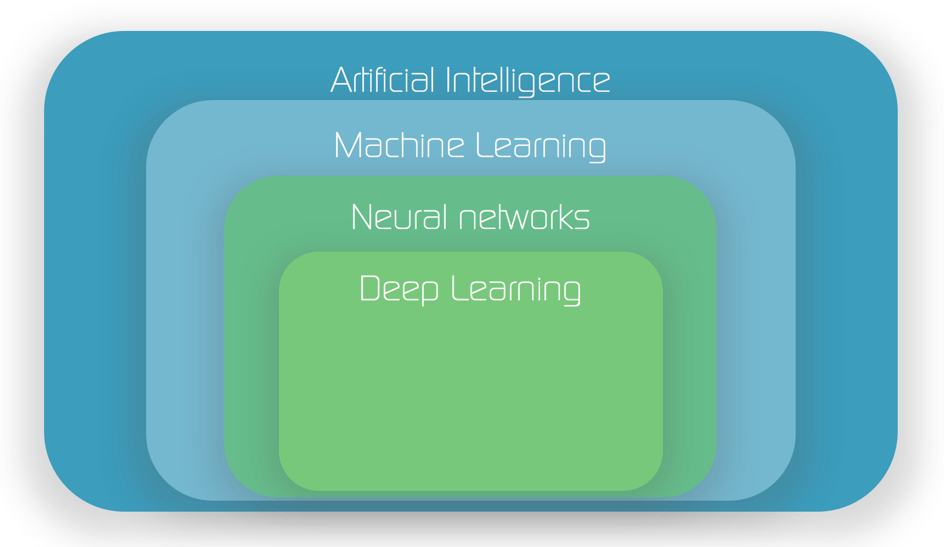

Artificial Intelligence, Machine Learning, Neuronale Netze und Deep Learning sind aktuell sehr populäre Buzzwords und sie werden häufig in einem Atemzug verwendet. Es gibt aber klare Unterschiede, und ich möchte daher hier kurz auf die Definitionen und Zusammenhänge eingehen.

Artificial Intelligence – Künstliche Intelligenz

Der Begriff Artificial intelligence wurde im Jahr 1956 von Marvin Minsky, John McCarthy und anderen Wissenschaftlern während eines Workshop im Dartmouth College geprägt.

AI dient als Oberbegriff für maschinelle Technologien zur Erbringung von Intelligenzleistungen und umfasst eine breite Palette von Methoden, Logiken, Verfahren und Algorithmen. Dies ist eine sehr weit gefasste Beschreibung, da selbst der Begriff „Intelligenz“ im Allgemeinen schwer zu definieren ist.

In der Regel geht es hierbei um Computerprogramme, die bestimmte menschliche „kognitive Fähigkeiten“ imitieren wie z.B. das Lernen von Zusammenhängen oder spezifische Problemlösungen.

Schwerpunkte der AI-Forschung sind z.B. die Verarbeitung von natürlicher Sprache (NLP), Lernen, Wissensverarbeitung, Planung. An der AI Forschung beteiligen sich neben der Informatik und Mathematik auch Neurowissenschaften, Soziologie, Philosophie, Kommunikationswissenschaft und Linguistik.

Machine learning – Maschinelles Lernen

Machine Learning ist eine Unterdisziplin der Artificial intelligence und bezieht sich auf statistische Techniken, durch die Maschinen auf Basis von gelernten Zusammenhängen Aufgaben ausführen.

Auf Basis von von gesammelten oder erhobenen Daten werden Algorithmen (eine Reihenfolge von definierten Schritten zur Erreichung eines Ziels) von Computern selbständig „erlernt“, ohne dass diese von einem Menschen programmiert zu werden.

Unter dem Obergegriff Machine Learng existiert eine Vielzahl von Algorithmen und Verfahren, z.B. Support Vector machines, Decision Tree, Random Forrest, Logistic Regression, Bayesian Networks, und-.... neuronale Netze.

Neural Networks - Neuronale Netze

Neuronale Netze sind Computermodelle zum maschinellen Lernen, die sich an der Struktur und Funktionsweise des biologischen Gehirns orientieren.

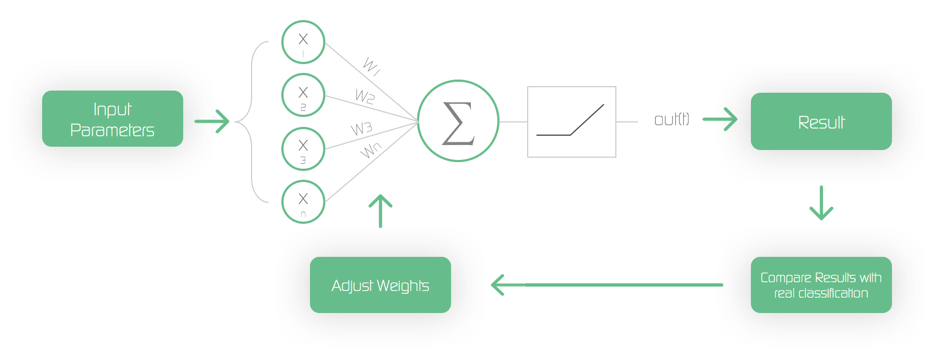

Ein künstliches Neuron verarbeitet hier mehrere Eingangssignale, und sendet wiederum, wenn die Summe der Eingangssignale einen gewissen Schwellwert übersteigt, Signale an weitere benachbarte Neuronen.

Hierbei kann ein einzelnes Neuron nur sehr einfache Berechnungen bzwl. Klassifizierungen durchführen. Schaltet man jedoch eine Vielzahl von Neuronen zusammen, in unterschiedlichen Architekturen, so lassen sich immer komplexere Sachverhalte lernen und entsprechende Operationenausführen.

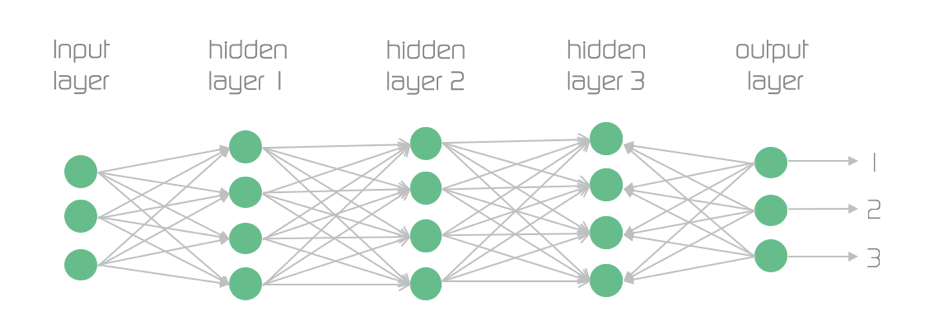

Einfache neuronale Netze enthalten einen Input Layer, an der die Eingangssignale (z.B. Bildinformatione) angelegt werden, einen Output-Layer, der für unterschiedliche Ergebnisse zuständige Neuronen enthält, und einen Hidden-Layer, über den Input-und Output Layer verknüpft sind.

Enthält eine Netz-Architektur mehr als einen Hidden-Layer, so spricht man von Deep-Neural-Networks oder ...

Deep-Learning

Deep-Learning ist der Bereich des maschinellen Lernens, der unser Leben in den nächsten Jahre am stärksten verändern wird.

Hierbei geht es um ein neuronales Netz, das mehr als einen Hidden-Layer hat. Aktuell in der Praxis eingesetzte Architekturen umfassen bis zu hundert Layern mit einigen zehntausend Neuronen.Mit diesen Netzen können sehr komplexe Aufgaben gelöst werden, z.B. Bilderkennung, Spracherkennung, Maschinelle Übersetzung und, und, und...

Ich werde in den folgenden Posts auf diesem Blog näher auf die spezifischen Topologien und deren Anwendunsgebiete eingehen ..... stay tuned.

AISO-Lab (Artificial Intelligence Solutions Laboratory) entwickelt KI-Lösungen für Unternehmen – von der Beratung über Pilotprojekte bis zur Produktionsübergabe.

Wir starten Deutschlands erstes Komplettangebot für die Entwicklung innovativer Anwendungen auf Basis von künstlicher Intelligenz. AISO-Lab wurde gegründet von Jörg Bienert, Michael Hummel und einem Team aus erfahrenen Data Scientists, Beratern und Projektmanagern in Köln und Berlin.

Die Gründer hatten bereits 2011 mit ParStream eines der ersten deutschen Big-Data Starts in Köln und dem Silicon Valley aufgebaut, bevor es 2015 von Cisco übernommen wurde.

"Mit AISO-Lab wollen wir diese Erfolgsstory fortsetzen und unsere Erfahrungen in der Umsetzung von innovativen Projekten und Produkten einbringen" sagt Jörg Bienert, CEO von AISO-Lab. "künstliche Intelligenz wird unsere Arbeit und unser Leben in vielen Bereichen revolutionieren." Wir stehen an einer ähnlichen Schwelle, wie beim Durchbruch des Internets Anfang 2000. Jedoch sind viele Unternehmen in Deutschland auf diese Umwälzung noch nicht vorbereitet."

Unser Angebot reicht von Einführungspräsentationen und Schulungen, über die Durchführung von detaillierten Evaluierungs-Workshops, Pilot-Implementierung bis hin zur kompletten Produktentwicklung und der Bereitstellung der erforderlichen Infrastruktur inklusive einer eigenen Hardware Appliance.

"Oft existiert in Unternehmen eine Lücke zwischen aktuellen Anforderungen, neuen Ideen und den Möglichkeiten, die die neuen Technologien im Bereich der KI bieten", betont Bienert. "Wir verstehen uns als Brückenbauer, um diese Lücke zu schließen und gemeinsam mit dem Kunden kreative Ideen zu entwickeln sowie innovative Produkte zu implementieren."