Wir freuen uns mitteilen zu können, dass die aiso-lab GmbH von der Alexander Thamm GmbH übernommen wurde. Wir sind jetzt Teil von Deutschlands führender Data Science Beratung mit mehr als 100 Mitarbeitern und der Erfahrung aus über 600 Projekten.

„Wir waren beeindruckt von der klaren Ausrichtung, der breiten Erfahrung und vor allem von der einzigartigen Unternehmenskultur bei Alexander Thamm. Daher war es für uns ein logischer Schritt, das Unternehmen mit Hauptsitz in München zu verstärken, um die KI-Positionierung zu unterstützen und das Geschäft in der Region West aus unserem Kölner Büro heraus auszubauen".

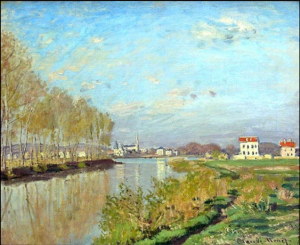

Was hat Claude Monet gesehen, als er dieses Bild gemalt hat?

Quelle: Unpaired Image-to-Image Translation using Cycle-Consistent Adversarial Networks

Quelle: Unpaired Image-to-Image Translation using Cycle-Consistent Adversarial Networks

Wäre die Farbfotografie 1873 schon erfunden gewesen, hätten wir auf diese Frage evtl. eine definitive Antwort. Aber auch ohne Farbfoto, wissen wir, dass es wahrscheinlich einen klaren blauen Himmel und einen Fluss, der den Himmel reflektiert, zeigen würde.

Die nächste Frage ist natürlich, was hätte Monet gemalt, wenn er vor einer anderen Landschaft seine Staffelei aufgestellt hätte.

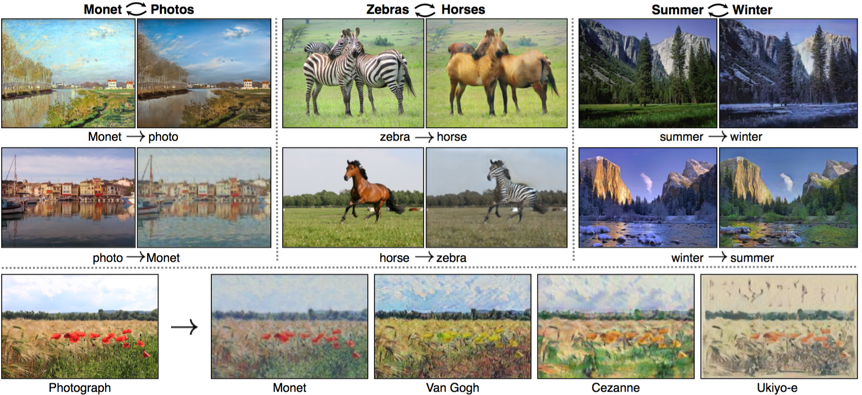

Wissenschafter von Berkeley AI Research haben in ihrem Paper "Unpaired Image-to-Image Translation using Cycle-Consistent Adversarial Networks“ einen Algorithmus entwickeln, der diese Frage mit Hilfe von KI beantworten kann.

Deren Ansatz ist ähnlich, wie wir als Menschen an die Aufgabe herangehen würden. Am einfachsten wäre es natürlich, ein Monet-Gemälde neben einem Farbfoto, der von ihm gemalten Szene zu sehen. Diese Daten haben wir aber leider nicht.

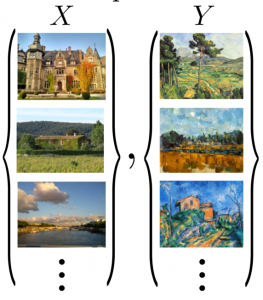

Statt dessen können wir uns z.B. Gemälde von Monet und Landschaftsbilder ansehen. Wenn wir danach ein Landschaftsbild betrachten, können wir uns mehr oder minder gut vorstellen, wie ein Gemälde von Monet aussehen würde, hätte er diese Szene gemalt. Dieser Vorgang funktioniert auch in die umgekehrte Richtung. Wenn wir uns ein Gemälde von Monet ansehen, können wir uns vorstellen, wie ein Landschaftsbild der gleichen Szene aussehen würde.

Dieses Gedankenexperiment lässt sich wie folgt formulisieren:

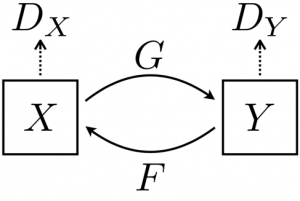

Wir haben als Trainingsdaten einen Datensatz X mit Landschaftsbildern und einen Datensatz Y mit Gemälden. Für diese Trainingsdaten, suchen wir eine Abbildung von Landschaftsbildern zu Gemälden und wieder zurück zu Landschaftsbildern.

Quelle: Unpaired Image-to-Image Translation using Cycle-Consistent Adversarial Networks

Das neuronale Netzwerk, das verwendet wird, um diese Abbildung zu finden, wird “Cycle-Consistent Adversarial Network” genannt. Cycle-Consistent Adversarial Networks können nicht nur Landschaftsbilder in Gemälde von verschiedenen Malern verwandeln, sondern auch Pferde durch Zebras ersetzen oder die Jahreszeiten auf Bildern ändern.

Quelle: Unpaired Image-to-Image Translation using Cycle-Consistent Adversarial Networks

Falls Sie wissen möchten, wie wir Ihnen helfen können noch mehr Wert aus Ihren Bilder zu schöpfen, kontaktieren Sie uns über info@aiso-lab.com.

Möchten Sie Ihre Leidenschaft für data entdecken? Dann besuchen Sie uns auf dem Data Festival 2019! Vom 20. bis 21. März im Muffatwerk in München soll dieses Festival die Gemeinschaft der Anwender und Datenexperten zusammenbringen! Der Schwerpunkt liegt auf Themen wie Data Science & Machine Learning, Data Engineering & Architecture, Data Visualization & Analytics.

Möchten Sie Ihre Leidenschaft für data entdecken? Dann besuchen Sie uns auf dem Data Festival 2019! Vom 20. bis 21. März im Muffatwerk in München soll dieses Festival die Gemeinschaft der Anwender und Datenexperten zusammenbringen! Der Schwerpunkt liegt auf Themen wie Data Science & Machine Learning, Data Engineering & Architecture, Data Visualization & Analytics.

Darüber hinaus gibt es am 19. März, einen Tag vor der Konferenz, einem spannenden Workshop bei dem Sie einen ersten Eindruck von dieser bereichern Veranstaltung gewinnen und Ihr Netzwerk erweitern können!

Tage:

19.03.2019 - Vorabend des Workshop-Tages

20.03.2019 - 21.03.2019 - Konferenz

Ort:

Vor-Workshop-Tag - Sofitel Hotel in München

Konferenz - Muffatwerk

Wir bieten Ihnen die exklusive Möglichkeit, die Veranstaltung (20. und 21. März) zu einem reduzierten Preis von 50% zu besuchen. Klicken Sie hier, um Ihre Tickets zu kaufen und verwenden Sie den Gutscheincode: SpeakerInvitAtion50%Bienert unter dem Feld Couponcode. Beeilen Sie sich! Dieses Angebot gilt nur für drei Personen.

Wir freuen uns auf Sie!

Die führende Konferenz zur Implementierung von KI in Ihrem Unternehmen findet am 21. und 22. März in München statt. Diese grandiose internationale Erfahrung wäre ohne den Beitrag des Handelsblattes und des AI-Summit nicht möglich: die wichtigen Partner von Business Events!

Neben den bedeutenden Beiträgen von KI-Managern verschiedener Unternehmen freuen wir uns, dass unser CEO und Präsident des KI-Verbandes Jörg Bienert anwesend sein wird, um die Aufgaben des KI-Verbandes und seine wesentliche Rolle bei der Unterstützung Deutschlands beim Aufholen neuer Technologien zu diskutieren.

Wir möchten zu Ihrer Teilnahme beitragen. Deshalb haben wir einen Sonderpreis für Sie! Abonnieren Sie jetzt unseren Newsletter und erhalten Sie die exklusive Möglichkeit, die Veranstaltung zu einem reduzierten Preis bis zu -100€ zu besuchen. Klicken Sie hier, um sich anzumelden und bleiben Sie auf dem Laufenden für unseren nächsten Newsletter!

Besuchen Sie zu uns für zwei Tage der Diskussionen und Inspirationen, und lassen Sie uns wertvolle Informationen und Erfahrungen austauschen und dabei unser Netzwerk erweitern.

Holen Sie sich noch heute Ihren ermäßigten Ticketpreis und seien Sie dabei! Seien Sie da, wo die Innovation ist!

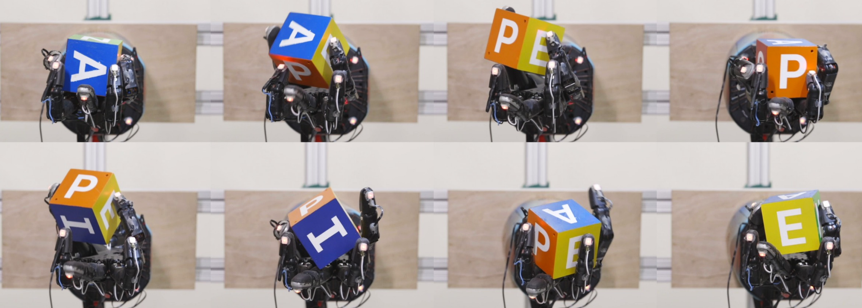

Quelle: Learning Dexterous In-Hand Manipulation https://arxiv.org/abs/1808.00177

Während die geschickte Handhabung von Objekten eine grundlegende alltägliche Aufgabe des Menschen ist, ist sie immer noch eine Herausforderung für autonome Roboter.

Da die menschliche Hand in der Lage ist, eine Vielzahl von Aufgaben in den verschiedensten Umgebungen mit grosser Geschicklichkeit auszuführen, ist das Herstellen einer künstlichenHand eines der inspierensten Ziele in der Robotik.

[video width="1184" height="736" mp4="https://aiso-lab.com/wp-content/uploads/2019/01/robotdexterity.mp4" autoplay="true" preload="auto"][/video]

Forscher von OpenAI haben jetzt mit Hilfe von KI einen grossen Schritt in diese Richtung gemacht (siehe https://arxiv.org/abs/1808.00177) und die Ergebnisse sind beeindruckend

<iframe width="560" height="315" src="https://www.youtube.com/embed/jwSbzNHGflM" frameborder="0" allow="autoplay; encrypted-media" allowfullscreen></iframe>

Im Folgenden die vier wichtigsten Schritte:

- mit einer grossen Anzahl von verteilten Simulationen werden Daten in Umgebungen mit zufälligen Variationen gesammelt;

- der nächste Steuerschritt wird basierend auf der Position des Objekts und basierend auf der Position der Fingerspitzen mit Hilfe eines LSTMs ausgewählt.

- aus drei simulierten Kamerabilder sagt ein neuronales Netzwerk die Position des Objekts vorher

- Punkte B) und C) werden für den Transfer in die reale Welt kombiniert

Einige überraschende Fakten zum Schluss:

- Die finale Version der Modelle wurde ohne reale Daten trainiert

- Taktile Wahrnehmung war nicht nötig

Wenn Sie Fragen zum Bereich Videoverarbeitung mithilfe von KI haben oder erfahren möchten, wie Sie Ihre Maschinen basierend auf Kamerainput automatisch ansteuern z.B. im Bereich der Qualitätssicherung, kontaktieren Sie uns gern unter: info@aiso-lab.com.

Sehr geehrte Freunde, Kunden und Partner von aiso-lab!

Seit dem 1. November 2018 befinden sich unsere Büros in einer neuen, schönen Location am Kölner-Heumarkt. Unsere neue Adresse lautet Gürzenichstraße 27, 50667 in Köln, im 4. Stock. Hier haben wir einen Blick aus der Vogelperspektive auf den Heumarkt, die Deutzer Brücke und den Rhein, während wir jederzeit eine tolle Atmosphäre genießen können!

Besuchen Sie uns für einer Tasse Kaffee oder einem Glas Gluhwein und genießen Sie fröhliche Momente auf dem Weihnachtsmarkt. Seien Sie Teil unserer Reise in die Welt der Künstlichen Intelligenz und lassen Sie sich von neuen digitalen Ansätzen und innovativen Ideen inspirieren!

Besuchen Sie uns für einer Tasse Kaffee oder einem Glas Gluhwein und genießen Sie fröhliche Momente auf dem Weihnachtsmarkt. Seien Sie Teil unserer Reise in die Welt der Künstlichen Intelligenz und lassen Sie sich von neuen digitalen Ansätzen und innovativen Ideen inspirieren!

Bitte notieren Sie sich den folgenden Termin:

- KI & Karneval am Donnerstag, 28. Februar 2019, ab 16:00 Uhr mit Impulsfokus auf Künstliche Intelligenz

- Karnevalsfinale in der Gürzenich-Festhalle ab 19:00 Uhr beim FEST IN BLAU der Kölner Funken Artillerie blau-weiß von 1870 e.V.

Weitere Details zur Tagesordnung werden in Kürze bekannt gegeben. Wir freuen uns über eine frühzeitige Anmeldung zur besseren Planung unserer Veranstaltungen.

Besuchen Sie uns jederzeit in den neuen Geschäftsräumen und zu unseren Veranstaltungen.

Wir freuen uns darauf, Sie bei uns begrüßen zu dürfen!

Ihr aiso-lab Team

Am 13. und 14. November wurde der VDE zur Hauptstadt der Zukunftstechnologien, zum 125-jährigen Jubiläum!

Auf dem VDE Tec Summit 2018 präsentierten und diskutierten fast 190 Referenten visionäre digitale Ideen. Darunter unser CEO und Präsident des KI-Verbandes Jörg Bienert, der das Potenzial der KI, die Erwartungen und wie unsere Dienstleistungen zu den Marktbedürfnissen beitragen können, aufgezeigt hat.

Außerdem betonte er die Rolle des KI Verbandes und seine wesentliche Verantwortung, Deutschland beim Aufholen neuer Technologien zu unterstützen.

Höhepunkt: der Jubiläumsabend mit technologiepolitischen Grundsatzreden von Bundeswirtschaftsminister Peter Altmaier und Siemens-Chef Joe Kaeser und die große Geburtstagsfeier - inklusive einer Reise ins All zur Internationalen Raumstation ISS.

Vielen Dank Tecsummit für diese aufregende Reise!

Unmittelbar nachdem die Bundesregierung letzte Woche ihre KI-Strategie vorgestellt hatte, wurde unser Geschäftsführer und Vorsitzender des Bundesverbandes KI in der 20:00 Uhr Tagessschau um eine Stellungnahme gebeten. Im Rahmen des Beitrages wurden dabei auch die Produkte der RAYPACK.AI GmbH im Bereich Objekt- und Personenerkennung gezeigt.

Die KI-Strategie ist ein sehr umfangreiches Dokument mit 77 Einzelmaßnahmen. Da aber konkrete Umsetzungspläne incl. zugehöriger Budges weitgehend fehlen, ist eine kurzfristige Konkretisierung unbedingt erforderlich. „Das Strategiepapier ist ein guter Startpunkt für einen intensiven Prozess, der jetzt mit allen Beteiligten umgehend gestartet werden muss. Ansonsten haben wir hier nur eine nette Ideensammlung.“

Klicken Sie hier für das Interview und kontaktieren Sie uns unter info@aiso-lab.de für weitere Informationen!

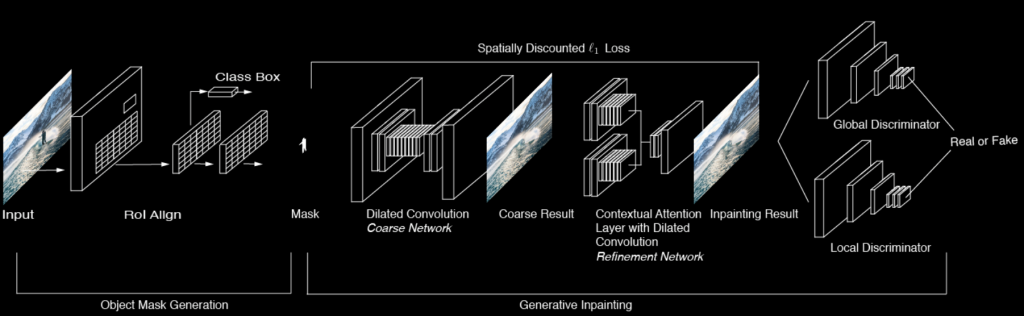

Wollten Sie schon mal Objekte verschwinden lassen?

Quelle: http://deepangel.media.mit.edu

Mit DeepAngel ist es jetzt möglich, Objekte aus Bildern verschwinden lassen. Das Projekt wurde von Forschern am MIT entwickelt und verwendet ein neuronales Netzwerk zum Entfernen von Objekten.

Dieses Algorithmus nutzt Detectron von Facebook AI Research zur Objekterkennung und DeepFill zum Impainting mit Hilfe eines neuronalen Netzes. D.h. zu entfernende Objekte werden von Detectron erkannt und von DeepFill so übermalt, dass sie von Hintergrund kaum mehr zu unterscheiden sind.

Quelle: http://deepangel.media.mit.edu

Wenn Sie Fragen zum Bereich Bildverarbeitung mithilfe von KI haben oder erfahren möchten, wie Sie aus Ihren Bildern oder Videos mehr Wert generieren können, kontaktieren Sie uns gern unter: info@aiso-lab.com.

Wir freuen uns, Sie zur KINNOVATE einzuladen, die vom Euroforum organisiert wird und am 11. und 12. Dezember 2018 in München stattfindet. Im Mittelpunkt dieser Veranstaltung steht die Implementierung von Lösungen der Künstlichen Intelligenz in der Geschäftspraxis. Sie erhalten einen Überblick über aktuelle Anwendungen und finden Partner für Pilotprojekte und konkrete Geschäftsmodelle.

Wir freuen uns darauf, unsere innovativen Use Cases und hochskalierbaren KI-Softwarelösungen wie Visual Computing zu präsentieren, die unter anderem unsere Kernkompetenz sind.

Wir möchten etwas zu Ihrer Teilnahme beisteuern. Deshalb haben wir einen Sonderpreis für Sie! Abonnieren Sie jetzt unseren Newsletter und erhalten Sie die exklusive Möglichkeit, die Veranstaltung zu einem reduzierten Preis bis -600€ zu besuchen. Klicken Sie hier, um sich anzumelden und bleiben Sie mit unserem nächsten Newsletter auf dem Laufenden!

Weitere Informationen zur Veranstaltung finden Sie hier.