Heute und in den nächsten zwei Tagen finden die Medientage in München statt. Wir freuen uns dort unsere Lösung zur AI basierten automatischen Indizierung von Videos und Archivmaterial präsentieren zu können.

Sie finden uns auf dem Stand der deutschen Telekom. Wir freuen uns auf Ihren Besuch!

Es war eine Ehre für aiso-lab, dass unser CSO, Dr. Alexander Lorz, bei der ELIV (Electroncis in Vehicles) einen Plenarvortrag über Künstliche Intelligenz gehalten hat. Weitere Sprecher am 16.10.2018 in Baden-Baden waren u.a. Prof. Shai Shalev-Shwartz, CTO Mobileye; Dr. Stefan Poledna, member of the executive board TTTech Computertechnik und Gero Schulze Isfort, CSMO Krone Commercial Vehicle.

Vielen Dank nochmal an das VDI Wissensforum.

Quelle: VDI Wissensforum

Über 2,66 Millionen Menschen haben gestern das Interview unseres CTO Gary Hilgemann mit Fabian Mader auf ARD, Deutschlands größtem Fernsehsender, verfolgt. Im Interview wurden die erstaunlichen Möglichkeiten, die die KI geschaffen hat, sowie wie die klaren Vorteile unserer Dienstleistungen und der enorme Investitionsbedarf in Entwicklung und Forschung in Deutschland hervorgehoben.

RAYPACK.AI und sein Schwesterunternehmen Rebotnix - für die Edge-Hardware - sind auf Visual Computing spezialisiert und bieten maßgeschneiderte, hochskalierbare AI-Softwarelösungen, die die Fertigung, die Qualitätskontrolle und andere grundlegende Geschäftsprozesse auf multinationaler Ebene unterstützen. Um dies zu erreichen, verwenden wir Rebotnix Gustav, ein hochzuverlässiges Hardwaregerät, sowie andere Geräte, welche es jedem leicht machen, unsere Visual Analyzer-Plattform zu nutzen.

Unser besonderer Dank gilt dem Report-Team München, Fabian Mader und Kollegen für ihren transparenten Bericht über den Status der KI in Deutschland.

Klicken Sie hier, um den gesamten Bericht sowie unsere Produkte und Anwendungsfälle zu sehen und um unsere Dienstleistungen besser verstehen zu können.

von Dr. Alexander Lorz und Ann Sophie Löhde

Wollten Sie schon immer wie Michael Jackson oder eine Primaballerina tanzen, aber haben einfach zwei linke Füße? Danke eines neuen KI-Algorithmus können Sie diesem Traum nun etwas näherkommen – zumindest auf Video!

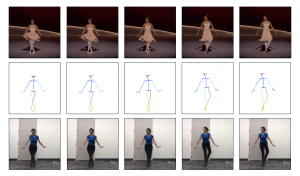

Sehen sie selbst:

https://www.youtube.com/watch?v=PCBTZh41Ris

Dieses Video zeigt den von Forschern der University of California, Berkeley, entwickelten KI-Algorithmus in Aktion. Deren Herangehensweise ist in dem Paper “Everybody Dance Now” beschrieben.

In diesem Quellvideo wird die Körperhaltung erkannt und als sogenannte “pose stick figure” (zu Deutsch: posierendes Strichmännchen) dargestellt. Diese Körperhaltung wird dann auf die Person im Zielvideo übertragen.

Damit dieser Prozess zeitlich kohärent abläuft, wird ein spezielles Generative Adversarial Network (GAN) eingesetzt. Darüber hinaus wird ein weiteres GAN verwendet, um die Gesichtsregion so detailliert und wirklichkeitsgetreu wie möglich darzustellen.

Dieser KI-Algorithmus eröffnet ganz neue Möglichkeiten für die Videobearbeitung. In Zukunft kann so jeder mit Hilfe von KI-Algorithmen Bewegungen und Aktionen auf Video ausführen, zu denen er normalerweise nicht in der Lage wäre. Durch diesen Fortschritt im Bereich KI wird es nahezu unmöglich reale und animierte Abläufe voneinander zu unterscheiden. Dies bietet neben vielen Vorteilen aber natürlich auch Gefahren. So wird man sich z.B. nicht mehr sicher sein können, wer die Bewegung in einem Video tatsächlich ausgeführt hat.

Wenn Sie Fragen zum Bereich Bildverarbeitung mithilfe von KI haben oder erfahren möchten, wie Sie aus Ihren Bildern oder Videos mehr Wert generieren können, kontaktieren Sie uns gern unter: info@aiso-lab.com.

Edge TPU ergänzt bestehendes Angebot und bietet Kunden erste Gesamtlösung für die Erstellung ihrer KI-Anwendungen

von Dr. Alexander Lorz und Ann Sophie Löhde

![]() Vor zwei Jahren hat Google seine Tensor Processing Units (kurz TPUs) vorgestellt - spezialisierte Chips, die in den ihren Rechenzentren KI-Aufgaben erleichtern. Jetzt bietet Google seine Expertise aus der Cloud als neue Edge TPU an. Der kleine KI-Chip kann komplexe Machine Learning (ML) Aufgaben in IoT-Geräten ausführen.

Vor zwei Jahren hat Google seine Tensor Processing Units (kurz TPUs) vorgestellt - spezialisierte Chips, die in den ihren Rechenzentren KI-Aufgaben erleichtern. Jetzt bietet Google seine Expertise aus der Cloud als neue Edge TPU an. Der kleine KI-Chip kann komplexe Machine Learning (ML) Aufgaben in IoT-Geräten ausführen.

Die Edge TPU wurde für "Inference" entwickelt, also die auf das Training folgende Anwendung des Algorithmus in seiner beabsichtigten Funktion: zum Beispiel ein fehlerhaftes Produkt auf einer Produktionsstraße erkennen. Im Gegensatz dazu sind Googles serverbasierte TPUs für das Training von ML Algorithmen optimiert.

Diese neuen Chips sind für den Einsatz in Unternehmen bestimmt, um Aufgaben wie Qualitätskontrolle in Fabriken zu automatisieren. Für diese Art von Anwendung hat ein Edge Device eine Reihe von Vorteilen gegenüber der Verwendung von Hardware, die Daten zur Analyse über das Internet senden muss. Inferenz auf dem Edge Device ist im Allgemeinen sicherer, zuverlässiger und liefert schnellere Ergebnisse. Soweit der Verkaufstext.

Google ist natürlich nicht das einzige Unternehmen, das Chips für diese Art von Edge KI-Anwendungen entwickelt. Allerdings bietet Google, im Gegensatz zu seinen Wettbewerbern, den gesamten KI-Stack. Kunden können ihre Daten in der Google Cloud speichern, KI-Algorithmen auf TPUs trainieren; und danach die trainierten KI-Algorithmen auf den neuen Edge-TPUs ausführen. Und höchstwahrscheinlich werden die Kunden auch ihre ML Software mit TensorFlow erstellen – dem eigens von Google entwickelten und betriebenen Coding-Framework.

Diese Art der vertikalen Integration hat klare Vorteile für Google und den Kunden. Google kann sicherstellen, dass all diese verschiedenen Teile so effizient und reibungslos wie möglich miteinander kommunizieren, dass es sich für den Kunden so einfach und effizient wie möglich gestaltet.

Google Cloud’s Vice President für IoT, Injong Rhee, sagte "Edge-TPUs sind als Ergänzung zu unserem Cloud-TPU-Angebot konzipiert, um das Trainieren von ML Algorithmen in der Cloud zu beschleunigen und dann blitzschnelle ML Inference auf dem Edge Device zu erreichen. Sensoren werden mehr als schlichte Datensammler - sie treffen lokale, intelligente Entscheidungen in Echtzeit."

Interessanterweise stellt Google das Edge TPU auch als Development-Kit zur Verfügung, das es den Kunden erleichtert, die Möglichkeiten der Edge Devices zu testen und zu sehen, wie sie zu ihren Produkten passen.

Das ist bemerkenswert, da Google bis jetzt der Öffentlichkeit keinen Zugang zu seiner KI-Hardware gewährt hat. Wenn das Unternehmen jedoch möchte, dass Kunden seine Technologie übernehmen, muss es sicherstellen, dass die Kunden sie zuerst ausprobieren können. Dieses Development Kit soll nicht nur neue Kunden ins Google Ökosystem locken - es ist ein Zeichen dafür, dass es Google ernst damit ist, den gesamten AI-Stack zu besitzen.

Sobald das angekündigte Development-Kit zur Verfügung steht, werden unsere Experten es natürlich sofort austesten. Bei weiteren Fragen stehen wir Ihnen natürlich immer zur Verfügung unter: info@aiso-lab.com.

Quelle: Google Blogs.

Der erste Schritt Ihres Kindes, der Ballettauftritt Ihrer Tochter oder der phänomenale Skateboardtrick Ihres Sohnes. Es sind genau diese Momente, die Sie nie mehr vergessen werden und trotzdem sind sie doch viel zu schnell vorbei und mit dem bloßen Auge nur schwierig zu erkennen. Haben Sie sich je gewünscht, genau diese Momente in Slow Motion ansehen zu können?

Videos mit 240 fps (frame-per-second) können heute mit einem Mobiltelefon aufgenommen werden, für höhere Bildraten sind jedoch immer noch professionelle High-Speed-Kameras erforderlich. Außerdem ist es nicht praktikabel, alles bei hohen Bildraten aufzuzeichnen - es erfordert große Speicherkapazität und ist für mobile Geräte zu energieintensiv. Wie wäre es, wenn es möglich wäre, diese Momente – häufig nicht einmal vorhersehbar – auch ohne eine unpraktische High-Speed Kamera in Slow Motion immer und immer wieder erleben zu dürfen?

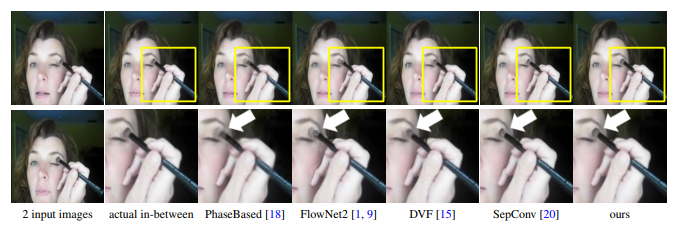

Mithilfe Künstlicher Intelligenz können Videos mit Standard-Frameraten nun nachträglich in Super Slow Motion Videos umwandeln werden.

Forscher der University of Massachusetts at Amherst, NVIDIA und der University of California, Merced haben ihr Paper "Super SloMo: High Quality Estimation of Multiple Intermediate Frames for Vide Interpolation" gerade veröffentlicht, in welchem sie alle Details Ihres Vorgehens erläutern.

Da wir gerade von Videos sprechen, wenn Sie Interesse haben, diesen Durchbruch in der KI Forschung besser zu verstehen, gucken Sie sich doch das folgende Video an, das bei der renommierten CVPR 2018 „Computer Vision and Pattern Recognition“ vorgestellt.

Am 04. und 05. Juli 2018 findet in Berlin die Konferenz „Künstliche Intelligenz“ statt. Neben Praxisbeiträgen von KI-Verantwortlichen bei Siemens, Trumpf, SAP, Bosch, Continental, Otto und vielen anderen werde ich einen Vortrag zur Einführung in Deep-Learning halten.

Ich freue mich auf einen spannenden Erfahrungsaustausch.

Für Abonnenten unseres Newsletters haben wir noch ein spezielles Angebot für Sie. Schauen Sie mal rein!

Viele Grüße

Jörg Bienert

Ist Künstliche Intelligenz so gefährlich, wie sie heute diskutiert wird? Während die negativen Auswirkungen der KI noch immer offen diskutiert werden, liegt der Fokus des Deutschen KI-Verbandes darauf, dies zu ändern.

Um diese Punkte klarzustellen gab unser CEO, Jörg Bienert, Vorstandsmitglied und Präsident, ein Interview mit Futurezone.de und diskutierte ausführlich über die Rolle der KI Verband, ihr Ziel und viele andere Aspekte, die eine Schlüsselrolle bei der Erlangung der Vorteile spielen, KI zu bieten hat. (zum Interview)

Am 15. März 2018 haben wir – 24 Unternehmen und Startups – den deutschen KI-Verband gegründet. In der konstituierenden Sitzung des Deutschen KI-Verbandes sprachen sich die Mitglieder für folgende Kernforderungen aus:

- innovationsfreundliche Rechtssicherheit in den Bereichen Zivil-, Steuer- und Datenrecht zu schaffen, um Deutschland als attraktiven Wirtschaftsstandort für das KI-Ökosystem zu etablieren und seine Wettbewerbsfähigkeit im internationalen Vergleich zu stärken.

- die menschenzentrierte und humane Nutzung von KI-Technologien zu fördern, um eine von der sozialen Marktwirtschaft geprägte Gesellschaft in das digitale Zeitalter zu führen.

- Förderung von Forschung, Entwicklung und praktischer Umsetzung von KI-Technologien durch Förderprogramme, Pilotprojekte, Anschubfinanzierung, Unterstützung der Zusammenarbeit zwischen Existenzgründern, Wissenschaft und etablierten Unternehmen.

- Förderung und Bildung und Wissenschaft zum Thema Künstliche Intelligenz und Aufklärung von Gesellschaft und Wirtschaft über Chancen und Risiken.

- Bildung einer KI-Expertenkommission mit Vertretern aus Politik, Wirtschaft (etablierte Unternehmen und Start-ups) und Wissenschaft zur aktiven Beratung der Bundesregierung.

Details hierzu finden sich in der Pressemeldung unter www.ki-verband.de.

Wir freuen uns auf die Arbeit mit den (mittlerweile 34) Mitgliedern und ich persönlich auch auf die Zusammenarbeit mit den Vorstandskollegen Rasmus Rothe (Merantix) und Fabian Behringer (ebot7) sowie dem politischen Beirat unter Leitung von Marcus Ewald (Thomas Jarzombek (CDU), Jens Zimmermann (SPD), Manuel Höferlin (Die Grünen) und Petra Sitte (Die Linke)).

Viele Grüße

Jörg Bienert

Es war ein tolles Event! Die erste – von uns mitorgangisierte – Handelsblatt KI-Konferenz gab zwei Tage lang einen exklusiven KI-Erfahrungsaustausch Ende vergangener in München. Diese Tage waren voll von hervorragenden Ideen, aufschlussreichen und wertvolle Informationenn und tiefen Einblicken in die Welt der Künstlichen Intelligenz!

Während dieser Veranstaltung hatten wir viele interessante Gespräche an unserem Stand, an dem wir unsere aktuellen use cases für Visual Computing mit AI zeigten. Wir haben uns sehr über viele neue Kontakte und das Treffen mit einigen Freunden aus unserem Netzwerk gefreut.

Unser besonderer Dank gilt dem Handelsblatt, dem Euroforum, den Referenten, Experten, Kollegen und allen Beteiligten.