Der Begriff künstliche Intelligenz (englisch: artificial intelligence, kurz A.I.) bezeichnet die Untersuchung und das Design intelligenter Verhaltensweisen von Maschinen. In seiner modernen Form entstand das Feld in den Fünfzigerjahren. In dieser frühen Phase herrschte – wie zur selben Zeit auch in anderen technologischen Bereichen – ein erheblicher Optimismus, dessen Versprechen aber in den folgenden Jahrzehnten nicht gehalten werden konnten. Abgesehen von grundsätzlichen Problemen wie der Fragen, was genau eigentlich Intelligenz ist und wie sie sich erkennen lässt, blieben konkrete Erfolge beim Entwurf glaubhaft intelligenter Systeme aus.

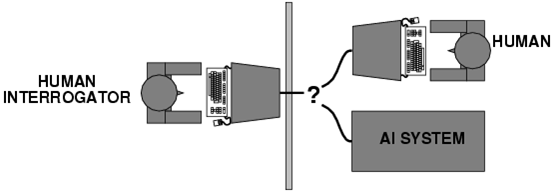

Kennzeichnend für diese neu entstandene Skepsis ist die wissenschaftliche Debatte, die sich rund um die Frage entwickelte, wie sich Intelligenz von Maschinen überhaupt nachweisen lasse. Bereits 1950 hatte Alan Turing den nach ihm benannten Turing Test vorgeschlagen. Bei diesem Test kommuniziert eine Testperson über einen Fernschreiber (Computerterminals gab es zu Turings Zeiten noch nicht) mit einem Gegenüber, von dem sie nicht weiß, ob es ein Computer oder ein Mensch ist. Wenn der Gesprächspartner ein Computer ist und die Testperson ihn dennoch als Mensch identifiziert, wäre dies, so Turing, der Beweis für die Intelligenz der Maschine.

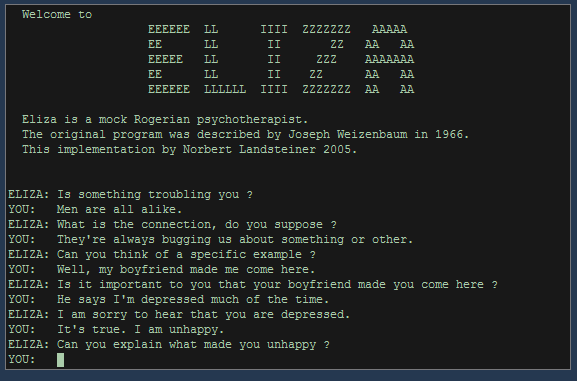

Die Methode des Turing Tests wurde im weiteren Verlauf der Debatte mehrfach kritisiert. In den Sechzigerjahren schuf Joseph Weizenbaum das Programm ELIZA, das nach heutigen Maßstäben recht einfach strukturiert war und einen Gesprächspartner in verschiedenen Rollen simulieren konnte. Zu Weizenbaums eigener Verblüffung gelang es ELIZA – vor allem in ihrer Rolle als Psychotherapeut – immer wieder, ihre menschlichen Gesprächspartner zu „täuschen“. Der pseudo-therapeutische Kontext legte allerdings auch nahe, dass es sich hierbei zumindest zum Teil auch um Projektion auf menschlicher Seite handelte: Die Testpersonen interpretierten mehr in die Äußerungen von ELIZA hinein, als wirklich zu lesen war.

Auch von philosophischer Seite gab es Einwände: 1980 entwarf John Searle das Chinese room argument. Bei diesem Gedankenexperiment befindet sich ein Mensch ohne Kenntnis der chinesischen Sprache im Kontext eines Turing Tests in einem Raum, ausgestattet mit allen erdenklichen Büchern und Ressourcen zur chinesischen Sprache und Kultur. Eine andere Person reicht diesem Menschen nun Fragen auf Chinesisch ein und erhält Antworten auf Chinesisch zurück. Searles Argument ist nun, dass der Mensch im chinesischen Zimmer Fragen lesen und beantworten kann, ohne auch nur ein Wort Chinesisch zu „verstehen“. Er ist damit in derselben Situation wie ein Computer, der vom menschlichen Nutzer Anfragen erhält und beantwortet (auf Chinesisch oder nicht). Die Maschine „versteht“ nicht, was vor sich geht, sie arbeitet lediglich auf Basis syntaktischer Regeln ohne Einblick in die Bedeutung ihres Inhaltes. Natürlich lassen sich gegen Searles Gedankenexperiment linguistische und sinologische Einwände erheben, aber es wirft eine sehr grundsätzliche Frage auf: Sind Intelligenz und Kommunikation reine Symbolverarbeitung auf syntaktischer Basis, oder gibt es so etwas wie eine tiefere semantische Ebene von Inhalt und Bedeutung?

Vor derart grundsätzliche Probleme gestellt, begannen sich Forschung und Entwicklung im Bereich künstlicher Intelligenz in zwei Hauptstränge aufzuteilen: Vorerst im Hintergrund blieb der Bereich der Artificial general intelligence, also der Entwurf von Maschinen, die sich aller erdenklichen Aufgaben mit intelligenten Methoden annehmen können. Verwandt, aber utopischer ist die strong A.I., die den exakten Nachbau menschlicher Intelligenz auf maschineller Basis anstrebt. Entscheidend ist hierbei, dass ein solcher Nachbau dem Vorbild gleichgesetzt wäre – die Simulation wäre dann mit dem Original identisch.

Wesentlich erfolgreicher operiert seit Längerem das Feld der narrow A.I., auch weak A.I. oder applied A.I. Hier wird maschinelle Intelligenz nur in eingeschränkten und spezialisierten Gebieten betrachtet. Beispiele hierfür sind:

- Problemlösungsstrategien

- Data-Mining

- Maschinelles Lernen

- Robotik

- Spracherkennung

- Schließen und Entscheiden auf der Basis unsicherer oder unscharfer Information

- Sehen und Mustererkennung

Viele dieser Gebiete haben in den letzten Jahrzehnten große Fortschritte erzielt. Suchmaschinen beherrschen Data-Mining und unscharfe Suchstrategien, mobile Assistenten in Smartphones erkennen das gesprochene Wort ihrer Benutzer fast fehlerfrei und greifen ihrerseits nahtlos auf Suchmaschinen zurück. Die Robotik hat sich zu einem Teilgebiet der künstlichen Intelligenz gemausert unter der Annahme, dass fundiertes Weltwissen als Grundlage von intelligentem Denken und Handeln nur durch physischen Kontakt mit der Wirklichkeit zustande kommen kann.

Die künstliche Intelligenz hat also einen weiten Weg zurückgelegt. Zwar kommuniziert man mit mobile Assistenten heute wie mit einem Menschen, aber die grundsätzlichen Fragen zur Intelligenz und zur Unterscheidung von Original und Simulation, syntaktischer Symbolverarbeitung und semantischem Verständnis, sind nach wie vor offen.

Zurück